China se suma a la regulación de la IA: ¿transparencia, control o influencia global?

Según cuenta Tom´s Hardware, a partir del 1 de septiembre de 2025, China comenzará a exigir el etiquetado obligatorio de todo contenido generado por inteligencia artificial. La medida, impulsada por la Administración del Ciberespacio de China (CAC), establece que textos, imágenes, vídeos, audios e incluso escenas virtuales deberán llevar marcas visibles o audibles que permitan a cualquier usuario identificar su origen artificial.

La decisión, aunque coherente con la trayectoria reguladora del país, no deja de sorprender por su coincidencia con una tendencia internacional más amplia. Tanto la Unión Europea como Estados Unidos están avanzando en sus propios modelos de regulación de la IA, aunque con enfoques distintos. La medida china marca así un punto de inflexión: no solo por lo que implica dentro de sus fronteras, sino por cómo se posiciona en la carrera global por controlar el desarrollo de esta tecnología.

La medida china: trazabilidad obligatoria y control reforzado

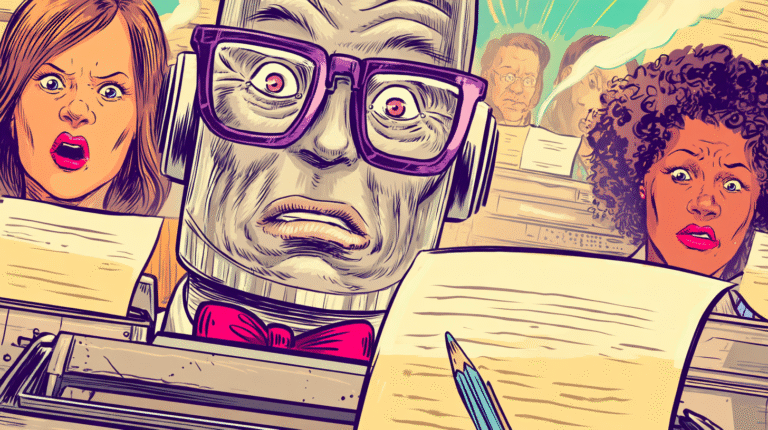

Según el marco publicado el 14 de marzo de 2025, los proveedores de servicios de IA deberán incluir etiquetas claras —ya sea texto, símbolos o señales de audio— en los contenidos generados, además de integrar metadatos específicos sobre su origen. Esta trazabilidad debe mantenerse intacta durante toda la vida útil del archivo.

Las plataformas digitales, como tiendas de aplicaciones y servicios online, estarán obligadas a verificar el cumplimiento de estas exigencias antes de permitir su publicación. También se prohíbe expresamente cualquier intento de eliminar o alterar las etiquetas, así como el uso o la oferta de herramientas que lo faciliten.

Más allá de la técnica, el objetivo es político: combatir la desinformación, prevenir fraudes y mantener el control narrativo en un entorno digital cada vez más automatizado. En un contexto donde las voces artificiales pueden simular declaraciones, discursos o situaciones, la trazabilidad se convierte en una herramienta de control, pero también de legitimidad.

Europa: un modelo de gobernanza centralizado y basado en derechos

La iniciativa china se asemeja —al menos en forma— a la estrategia regulatoria que la Unión Europea viene desarrollando con su AI Act, adoptado en 2024. Este marco establece, entre otras obligaciones, que cualquier contenido generado o manipulado mediante IA debe ser etiquetado como tal, especialmente si puede inducir a error a las personas.

La diferencia principal está en el enfoque: mientras la UE parte de la protección de derechos fundamentales, como la privacidad o la libertad de expresión, China adopta una lógica centrada en el control interno y la gestión centralizada de la información. Ambos sistemas promueven la trazabilidad, pero con fines y garantías muy distintos.

Aun así, la coincidencia normativa revela una preocupación común: la necesidad de establecer límites claros ante una tecnología que difumina la línea entre lo real y lo simulado. La transparencia del origen ya no es solo un principio ético; es una exigencia operativa en la era de los contenidos generados por máquinas.

Estados Unidos: fragmentación, dinamismo y foco en el sector privado

Frente a la centralización europea y el control estatal chino, Estados Unidos avanza por una tercera vía: descentralizada, orientada al mercado y en constante evolución. En ausencia de una ley federal integral sobre IA, la regulación está en manos de los estados, lo que ha generado un mosaico legal complejo pero activo.

En 2024 se introdujeron más de 600 proyectos de ley relacionados con IA en 45 estados. Algunos casos, como el Colorado AI Act (que entrará en vigor en 2026), apuntan hacia regulaciones amplias y exigentes. Otros, como en California, se centran en ampliar la protección de datos personales ante el uso de sistemas algorítmicos.

Las tendencias comunes entre los estados incluyen la exigencia de transparencia sobre el uso de IA, la regulación de contenidos sintéticos (especialmente en contextos electorales o sexuales), y la obligación de realizar evaluaciones de impacto en sistemas de alto riesgo. A esto se suman iniciativas federales como la orden ejecutiva firmada por el presidente Biden en 2023 y el marco de gestión de riesgos del NIST.

Aunque este enfoque descentralizado plantea desafíos para las empresas que operan a escala nacional o internacional, también refleja la capacidad de adaptación y la presión del sector privado como actor regulador de facto.

Un panorama global que se redefine

La regulación china no es un gesto aislado ni puramente interno. Marca una fase en la que las tres grandes potencias tecnológicas —China, Europa y EE.UU.— comienzan a consolidar modelos normativos propios para gobernar la inteligencia artificial. Y aunque sus motivaciones y métodos difieren, el destino común parece inevitable: una IA más trazable, más auditada y más sujeta a marcos de responsabilidad.

Para las empresas tecnológicas, esto implica adaptarse a entornos regulatorios múltiples y en constante evolución. Para los ciudadanos, abre preguntas fundamentales sobre la confianza, la autenticidad y el poder. ¿Quién define lo que es aceptable en un sistema algorítmico? ¿Cómo se asegura que la regulación no se convierta en censura o en barrera para la innovación?

La medida de China no solo refuerza su control interno: también le permite participar en el debate internacional sobre cómo debe regularse la IA. En ese sentido, no es una concesión, sino una jugada estratégica.