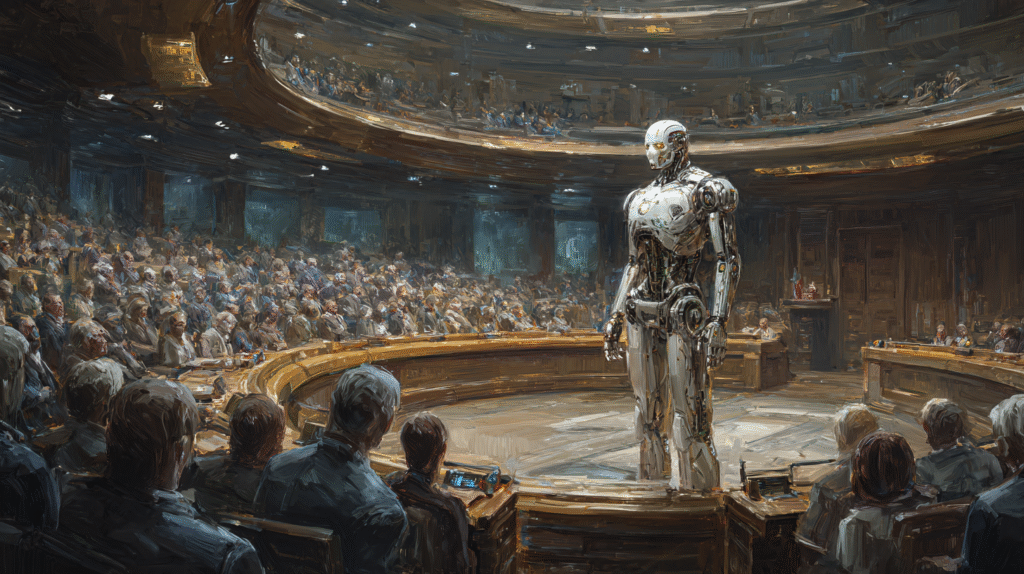

¿Puede un estado liderar la regulación global de la IA?

El RAISE Act, aprobado por la legislatura de Nueva York, emerge como un caso paradigmático de regulación estatal en un contexto federal como el de Estados Unidos. La ley exige a los desarrolladores de inteligencia artificial la publicación de protocolos de seguridad, la retención obligatoria de datos durante cinco años y la postergación del despliegue de modelos catalogados como “críticamente riesgosos”.

A diferencia de las declaraciones generales o principios éticos adoptados por otras jurisdicciones, esta norma introduce obligaciones concretas y verificables, impulsando un modelo de transparencia técnica y trazabilidad. En la práctica, convierte a Nueva York en un laboratorio regulatorio que desafía la inercia del sistema federal estadounidense, tradicionalmente reticente a imponer restricciones anticipadas sobre innovaciones emergentes.

Federalismo digital: la autonomía estatal frente a la inacción federal

El caso del RAISE Act pone de relieve una particularidad estructural del sistema jurídico estadounidense: la preeminencia de los estados en muchas competencias que afectan la vida tecnológica y económica. Aunque el Congreso discute una posible moratoria federal sobre IA de alto riesgo, carece hasta ahora de una hoja de ruta legislativa coherente. En este vacío, los estados —como ocurrió con la privacidad en California o las criptomonedas en Wyoming— actúan como motores de experimentación normativa.

Sin embargo, esta descentralización conlleva riesgos: fragmentación jurídica, inseguridad regulatoria para los desarrolladores y conflictos de preeminencia entre marcos estatales y federales. La paradoja es clara: en nombre de la innovación, el gobierno federal ha evitado intervenir, dejando que cada estado fije sus reglas en un ámbito con profundas implicaciones transfronterizas.

El modelo europeo: coherencia, centralización y vigilancia ex ante

En marcado contraste, la Unión Europea ha optado por un enfoque centralizado y estratificado. La recientemente adoptada Ley de Inteligencia Artificial establece una clasificación por niveles de riesgo, donde los sistemas de “alto riesgo” deben cumplir con obligaciones detalladas: desde la gestión de datos y documentación técnica, hasta auditorías de ciberseguridad y mecanismos de supervisión humana.

A nivel institucional, la gobernanza recae en una Oficina de IA dependiente de la Comisión Europea, que actúa como ente coordinador y fiscalizador en todo el mercado único. Esta estructura refleja una lógica regulatoria basada en la armonización ex ante, con plazos precisos de entrada en vigor y obligaciones comunes para desarrolladores dentro y fuera de la UE. A diferencia del modelo estadounidense, donde los marcos emergen de forma reactiva y dispersa, el enfoque europeo busca anticipar los riesgos sistémicos antes de que ocurran.

¿Regulación significativa o gesto político?

El RAISE Act plantea una cuestión incómoda: ¿es posible que un solo estado, por más avanzado que sea, fije estándares globales en una tecnología que se desarrolla de forma transnacional? Desde un punto de vista simbólico, la ley cumple una función crucial: introduce responsabilidad jurídica donde antes solo había declaraciones voluntarias. Sin embargo, su eficacia dependerá de su capacidad para atraer adhesión más allá de su jurisdicción.

Frente al modelo europeo, más denso en términos técnicos e institucionales, el enfoque neoyorquino puede parecer frágil o incluso testimonial. No obstante, también encarna una lección: en sistemas federales, la regulación significativa puede surgir desde lo local cuando lo nacional falla. La pregunta final, entonces, no es si regular es posible, sino qué tipo de arquitectura legal permite hacerlo con legitimidad, coherencia y eficacia.