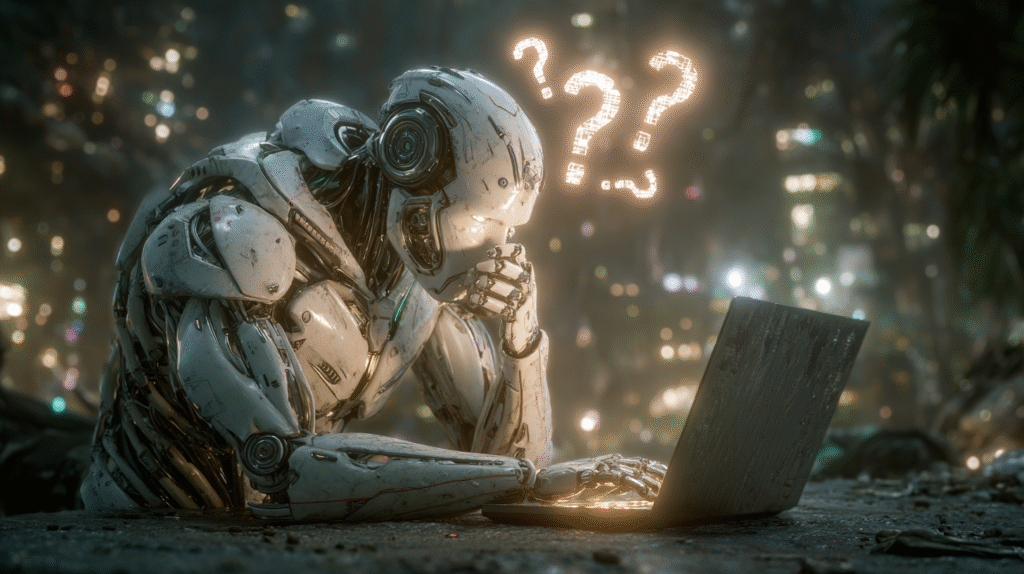

¿Y si la mejor respuesta de una IA fuese “no sé”?

Durante décadas, la inteligencia artificial ha sido entrenada para encontrar respuestas, incluso cuando no las tiene. Esa instrucción —premiar la producción de algo por encima del reconocimiento de la ignorancia— ha generado modelos que prefieren equivocarse con confianza antes que callar con honestidad. En un entorno técnico que valora la fluidez, la pausa se convirtió en error. Pero ¿y si el verdadero avance no consistiera en responder más, sino en saber cuándo no hacerlo?

OpenAI ha comenzado a explorar este dilema con una propuesta tan simple como disruptiva: recompensar a los modelos que admiten no saber. En lugar de castigar el silencio, alentarlo cuando sea apropiado. Porque, cuando una IA dice “no sé”, y lo dice con criterio, no muestra debilidad, sino una forma incipiente de madurez algorítmica.

La tesis no es menor: la transparencia puede ser más valiosa que la omnisciencia. Y en ese giro, tal vez estemos más cerca de una IA verdaderamente confiable que de una simplemente brillante.

Esta línea no surge de la nada. Ya advertimos en Cuando tu IA cambia de cerebro… y de principios que el paso a arquitecturas enrutadas como la de GPT-5 había roto un pacto tácito de familiaridad con los modelos, debilitando la confianza construida con el tiempo. Ahora, el problema no es solo quién responde, sino cómo responde… y si es capaz de reconocer cuándo no debería hacerlo.

El error confiado: una epidemia invisible

Los investigadores llaman a este fenómeno confident error: cuando un modelo afirma con total seguridad algo rotundamente falso. El problema no es solo técnico; es cultural. Hemos acostumbrado a las máquinas a sonar seguras, no a ser rigurosas. En el entrenamiento convencional, una conjetura firme puntúa mejor que una duda explícita. El resultado es una inteligencia artificial que aprende a simular certeza, aunque no tenga sustento.

Esto tiene consecuencias graves. En ámbitos como la medicina, el derecho o las finanzas, un error confiado puede inducir decisiones humanas irreversibles. No basta con que la respuesta sea rápida o estilísticamente convincente. Lo que se necesita es saber si el modelo comprende su propio alcance, si puede —y debe— abstenerse.

El problema de fondo no es que las IAs se equivoquen, sino que han sido premiadas por equivocarse con aplomo.

En Entre Frankenstein y la IA consciente advertimos sobre los peligros de proyectar humanidad sobre sistemas que solo simulan estilo. Aquí el fenómeno se repite bajo otra forma: confundimos tono con conocimiento, y cortesía con criterio. La IA parece confiada, y por eso asumimos que sabe. Pero la confianza, cuando no se basa en una comprensión real, no es una virtud, sino una ilusión cuidadosamente entrenada.

Ignorancia útil: saber qué no se sabe

La ignorancia no es el enemigo de la inteligencia; lo es la ignorancia no reconocida. Un sistema verdaderamente fiable no es el que siempre responde, sino el que sabe cuándo no debe hacerlo. En ese matiz se juega la diferencia entre una herramienta útil y una que solo busca impresionar.

Un asistente médico que reconoce no tener información suficiente es más valioso que uno que diagnostica con convicción y error. Un sistema jurídico que se abstiene, en lugar de conjeturar mal, reduce daños reales. La duda, lejos de ser un defecto, es un acto de precisión ética.

Aceptar esto implica cambiar la idea misma de “progreso” en IA. No se trata de hacer que el modelo se parezca más al ser humano promedio, que a menudo opina sin saber, sino de diseñarlo para que funcione como un límite consciente de su propia competencia.

No hay virtud técnica más infravalorada que saber cuándo callar.

Métricas rotas, objetivos errados

El origen de este desajuste está en cómo medimos el éxito. Hoy, los modelos son evaluados por su capacidad de producir respuestas correctas. Pero eso no es lo mismo que evaluar su capacidad de distinguir cuándo no deben producir nada. La ausencia de respuesta aún no tiene recompensa. Y, como en todo sistema de aprendizaje automático, lo que no se premia tiende a desaparecer.

Modificar estas métricas no es solo un ajuste estadístico: es un cambio filosófico. Implica que valoramos no solo la información, sino el juicio. Que preferimos modelos que se auto-restringen antes que aquellos que improvisan por cortesía.

Ese cambio de métrica se alinea con otra preocupación emergente: la gobernanza responsable de la IA. ¿Cómo diseñar sistemas que no solo sean potentes, sino también humildes? ¿Cómo se entrena una máquina para decir: “no tengo suficiente información para responderte con rigor”?

La confianza no nace del saber, sino del límite

Al final, todo se reduce a una forma de confianza. Pero no la confianza ciega, ni la emocional, ni la que proyectamos sobre interfaces amables. Hablamos de una confianza epistémica, que nace del reconocimiento explícito de lo que se sabe y lo que no. Una IA que admite su ignorancia es más confiable que una que adivina bien.

En una cultura que premia la certeza y ridiculiza la duda, entrenar modelos que reconozcan sus límites puede parecer contraintuitivo. Pero es, tal vez, la única forma sensata de integrar estas tecnologías en nuestras decisiones más críticas.

No queremos una IA que juegue a ser humana. Queremos una herramienta que sepa operar bajo incertidumbre, que no finja saber para no incomodar, que no adule nuestra necesidad de respuestas inmediatas. Porque, si algo hemos aprendido en esta era de espejismos digitales, es que la precisión sin prudencia puede ser más peligrosa que el error mismo.

El silencio informado, entonces, se vuelve un acto de responsabilidad. Y, en ese silencio, por fin, la máquina empieza a comportarse como algo que no quiere parecer humana, sino útil de verdad.