¿Puede la escuela sobrevivir a la era de la IA?

La irrupción masiva de herramientas como ChatGPT, Gemini o Claude ha reconfigurado el entorno educativo de forma radical. Según datos recientes, el 90% de los estudiantes universitarios ya ha utilizado IA generativa para apoyar su estudio, y uno de cada cuatro adolescentes también. Esta adopción vertiginosa no ha venido acompañada de un marco regulador sólido.

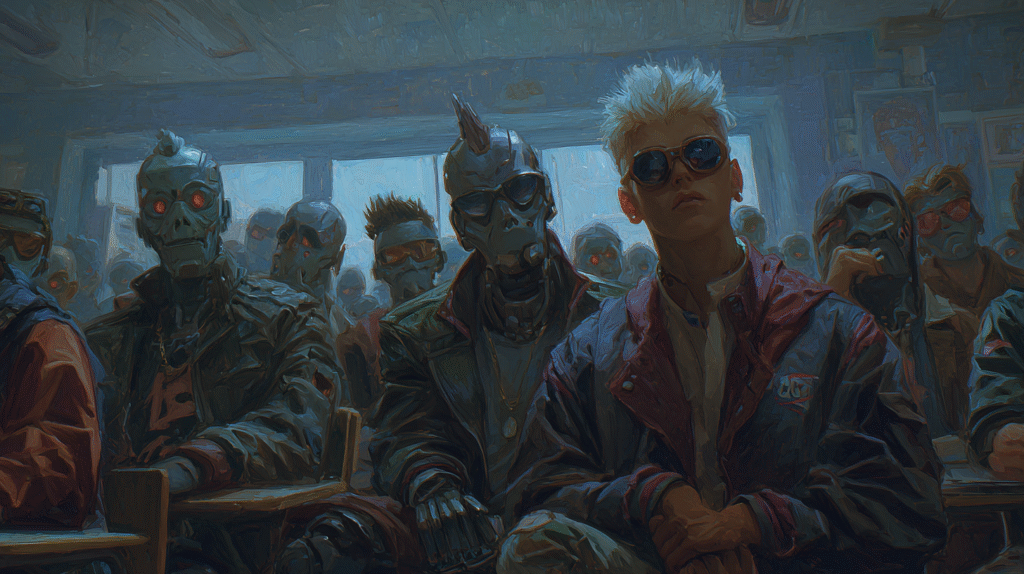

Al contrario, lo que observamos es una desconexión entre la velocidad tecnológica y la capacidad institucional para adaptarse. En las aulas, la IA no se discute como herramienta, sino como amenaza. La consecuencia es un ambiente ambiguo, en el que alumnos y profesores operan bajo reglas no escritas, temerosos de cometer errores que aún nadie ha definido con claridad.

Profesores divididos, criterios opuestos: pedagogía sin consenso

El desconcierto no solo afecta a los estudiantes. El cuerpo docente se encuentra fragmentado frente al mismo fenómeno. Mientras algunos profesores penalizan el uso de ChatGPT por considerarlo una forma de plagio digital, otros lo promueven como parte del proceso de aprendizaje. Esta disparidad genera una sensación de arbitrariedad que erosiona la legitimidad pedagógica.

La falta de lineamientos institucionales convierte el uso de IA en una cuestión de azar: lo que se permite en una asignatura puede ser motivo de sanción en otra. Esta falta de criterios compartidos no solo afecta la evaluación académica, sino que socava la confianza entre docentes y estudiantes, en un momento donde la claridad debería ser la brújula del aprendizaje.

Entre lo surrealista y lo sintomático: estudiantes piden perdón con IA

El desconcierto ha dado lugar a situaciones que rozan el absurdo. Se han documentado casos de estudiantes que, tras ser descubiertos usando inteligencia artificial, optan por escribir cartas de disculpa… generadas con IA. Este gesto, lejos de ser una simple anécdota, revela una paradoja profunda: el uso de la tecnología no se abandona ni siquiera cuando se trata de reconocer su uso indebido.

Lo que en otro tiempo se habría considerado una falta académica, hoy se diluye en un terreno donde las reglas cambian constantemente. Estas escenas no solo reflejan una cultura de evasión, sino un síntoma más grave: la educación parece haber perdido su capacidad para ofrecer referentes claros. En lugar de formar con sentido, se sobrevive con estrategias.

De la trampa al criterio: herramientas como DocuMark y el nuevo pacto formativo

En medio de esta incertidumbre, algunas iniciativas ofrecen alternativas viables para integrar la IA con criterio. DocuMark, una herramienta desarrollada por Enago y Trinka AI, propone un enfoque híbrido: permite detectar indicios de generación automática en textos académicos, pero lo hace con trazabilidad y sin castigos automáticos. Cada institución puede configurar sus parámetros éticos, transformando la detección en oportunidad formativa.

Este modelo encarna un nuevo paradigma: entender antes de sancionar. Ejemplos como el de los Emiratos Árabes Unidos, que han introducido ChatGPT desde la infancia junto a un marco nacional de alfabetización digital, demuestran que la IA no solo se controla: también se puede enseñar, regular y asimilar desde la base.

A su vez, propuestas como el “modo aprendizaje” de Claude obligan a replantear qué significa realmente aprender. Aunque estas plataformas ofrecen una experiencia personalizada y eficiente, también pueden fomentar una externalización del pensamiento. Si todo se resuelve sin esfuerzo, ¿dónde queda el error, la intuición, la construcción del criterio? La inteligencia artificial puede ser mentora, pero no debe reemplazar el proceso humano de comprender.

En última instancia, no se trata de evitar la IA, sino de formar para usarla con juicio. Herramientas como DocuMark son útiles no por lo que prohíben, sino por lo que hacen posible: recuperar el aula como espacio para el pensamiento crítico, no solo para ejecutar tareas.