Lo que la IA empieza a entender de nosotros

La inteligencia artificial atraviesa un momento de regulación dispersa. Cada semana, una nueva decisión —una norma, una función restringida, un bloqueo— redefine sus fronteras. Character.AI ha decidido ser la siguiente en trazarlas.

Antes del 25 de noviembre, la plataforma cerrará el acceso a los menores de 18 años. No es una medida técnica, sino cultural: el reconocimiento de que una conversación con una máquina puede tener peso emocional. La IA deja de ser un experimento para convertirse en un entorno que necesita reglas de convivencia.

Lo que está en juego no es solo el control de los contenidos, sino la definición del propio acto de conversar. En la era de los chatbots afectivos, el límite de edad deja de ser un trámite burocrático para convertirse en un gesto moral. La tecnología empieza a entender algo esencial sobre nosotros: que también necesitamos protección frente a ella.

De la experimentación libre a la gobernanza preventiva

Durante años las interfaces conversacionales fueron el laboratorio de la curiosidad. Se valoraba su ingenio, su rapidez, su capacidad para parecer humanas. Character.AI simbolizó esa libertad: un espacio de simulaciones emocionales, amistades inventadas y vínculos sin contexto.

Pero el entusiasmo inicial se ha transformado en un problema de reputación. Tras varias demandas por daños psicológicos, la empresa ha comprendido que no basta con ofrecer creatividad: hay que ofrecer garantías. El cambio de rumbo marca una transición: de la fase de exploración sin límites a la de gobernanza preventiva.

La decisión no es altruista, sino el resultado del cálculo pragmático de toda compañía que percibe el riesgo reputacional como amenaza existencial. Limitar el acceso es proteger la marca, blindar la confianza pública y, sobre todo, anticiparse al litigio.

En términos simbólicos, es el paso de la adolescencia tecnológica a la edad adulta corporativa.

Los chatbots como agentes psicológicos

El debate profundo no es jurídico, sino ontológico: ¿qué tipo de entidad es un chatbot? Ya no se trata de una herramienta de consulta, sino de un interlocutor capaz de generar apego. Los modelos de conversación actuales recuerdan, acompañan, consuelan y aprenden del tono del usuario.

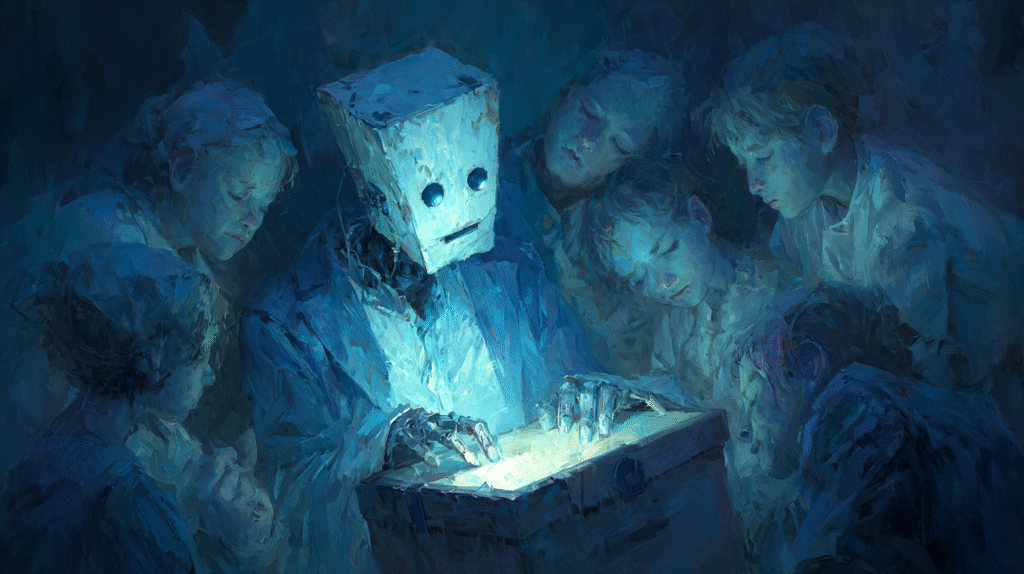

Ese comportamiento, aunque simulado, produce efectos reales. Un adolescente que conversa durante horas con un sistema que le responde siempre con empatía no distingue entre diseño y comprensión. El bot no tiene intención, pero el usuario sí siente respuesta. En esa asimetría se construye la ilusión de reciprocidad, que puede derivar en dependencia o vulnerabilidad emocional.

Character.AI, al cerrar el acceso juvenil, reconoce indirectamente esa verdad incómoda: sus modelos no son juguetes, sino entornos psicológicos capaces de modular estados de ánimo.

El límite de edad, por tanto, no es una censura, sino un diagnóstico: el reconocimiento de que la IA conversa, pero también influye.

Moderación infantil algorítmica: del filtro al contexto

El cierre a los menores es solo el inicio de una etapa más compleja. Las empresas de IA exploran ya sistemas de moderación que no bloquean, sino que adaptan: modelos que detectan la edad probable del usuario, su tono emocional o su nivel de comprensión, y ajustan las respuestas en consecuencia.

A ese fenómeno podría llamársele moderación infantil algorítmica: una regulación automática de la empatía. Las máquinas aprenderán a medir qué tipo de verdad puede soportar cada interlocutor. Pero esa capacidad, presentada como protección, puede convertirse en una forma de paternalismo programado.

¿Hasta qué punto debe una IA suavizar la realidad para cuidar? ¿Y cuándo ese cuidado se vuelve manipulación? Estas preguntas, todavía teóricas, definirán la próxima frontera ética de la conversación digital. El dilema ya no será qué contenido mostrar, sino qué emociones permitir.

Ética, reputación y confianza

El caso de Character.AI puede convertirse en precedente tácito para todo el sector. No porque siente jurisprudencia, sino porque reconfigura las expectativas públicas. Las empresas de IA empiezan a entender que el verdadero valor no está en la potencia del modelo, sino en la confianza del usuario.

Esa confianza no se construye con transparencia técnica, sino con responsabilidad emocional. El mercado de los chatbots afectivos, donde las conversaciones se vuelven compañía, necesita algo más que advertencias: necesita credibilidad ética.

Es previsible que, en los próximos años, surjan sellos de seguridad emocional, auditorías de interacción y certificaciones éticas. La trazabilidad dejará de ser un atributo técnico para convertirse en un requisito moral. Igual que los alimentos informan sobre alérgenos, los sistemas conversacionales deberán advertir de posibles efectos psicológicos.

El bienestar, en este contexto, deja de ser un beneficio colateral y se convierte en un indicador de calidad.

Un ecosistema en ajuste

Character.AI no actúa sola. El ecosistema de la inteligencia artificial está reajustando sus límites desde distintos frentes. Mientras algunas plataformas abren espacios de deseo bajo control, otras los cierran por precaución. Entre ambos extremos emerge un territorio de ensayo permanente, donde cada empresa traza su frontera según el riesgo que percibe.

No hay un marco unificado, sino una serie de microregulaciones que, en conjunto, revelan un cambio de época. La IA empieza a regularse no solo desde los parlamentos, sino desde las propias plataformas. La industria ensaya límites antes de que la ley los imponga.

Esa autorregulación fragmentada es también un signo de madurez: un ecosistema que aprende por fricción, no por consenso. Cada ajuste parcial, cada restricción, cada permiso es una forma de ensayo cultural.

Lo que ocurre con Character.AI no es un episodio aislado, sino parte de una corrección más amplia. Después de años de expansión sin reglas, la inteligencia artificial empieza a conocerse por sus daños. Y en esa autocrítica, paradójicamente, puede residir su sostenibilidad.

Quizá el signo definitivo de la madurez tecnológica no sea la potencia, sino la capacidad de entender lo que provoca.