Errores invisibles en la IA: cómo la sobreconfianza amenaza la fiabilidad

En un artículo reciente, el analista tecnológico Azeem Azhar planteaba una preocupación creciente: cuanto más avanzados son los modelos de inteligencia artificial, más peligrosos se vuelven sus errores, no por su frecuencia, sino por su invisibilidad. Es decir, lo que falla no es tanto el sistema, sino nuestra percepción de él. Esta tesis cobra especial relevancia en contextos editoriales, donde un error factual —como confundir a un senador ya electo con un “aspirante”— puede pasar desapercibido precisamente porque fue redactado con seguridad y elegancia.

Lo que debería levantar una alerta se oculta bajo una sintaxis impecable. En nuestra experiencia, este tipo de errores tienden a no ser detectados por los modelos de lenguaje más avanzados, mientras que versiones más simples, paradójicamente, sí lo identifican. Este fenómeno plantea una pregunta inquietante: ¿estamos confiando más justo cuando deberíamos ser más cautelosos? En la era de los modelos tipo GPT-4o y Claude Opus, la certeza se ha vuelto un producto de diseño más que de precisión.

El caso editorial: el error que pasó de largo ante la sofisticación

El error no parecía grave a simple vista: un modelo de IA se refería a un político como “aspirante al Senado”, cuando en realidad ya había sido elegido y juramentado semanas antes. Lo notable no fue el fallo en sí, sino que este pasó desapercibido para los sistemas de revisión asistidos por inteligencia artificial más avanzados. Por contraste, modelos de generaciones anteriores, como GPT-3.5 o equivalentes de código abierto, sí detectaron la incongruencia.

Esto revela una paradoja que va más allá del rendimiento técnico: los modelos más sofisticados no necesariamente ofrecen mejores garantías de precisión factual. De hecho, su forma pulida de expresarse tiende a relajar los mecanismos de verificación humana. En entornos editoriales, donde los tiempos de revisión son reducidos y la confianza en la IA está en aumento, este tipo de errores puede escalar sin control. Lo que debería haber sido una observación trivial se convierte en síntoma de un problema mayor: la creciente dificultad para identificar errores en outputs demasiado convincentes.

Sobreconfianza epistémica: el enemigo invisible

El caso anterior no es aislado. Un estudio reciente de la Universidad de Stanford ha documentado el fenómeno de la sobreconfianza epistémica en los grandes modelos de lenguaje: una tendencia a expresar certeza lingüística incluso cuando la probabilidad de estar en lo correcto es baja. Esto genera un problema doble. Por un lado, el modelo “cree saber” más de lo que sabe realmente; por otro, el usuario interpreta esa seguridad como sinónimo de precisión.

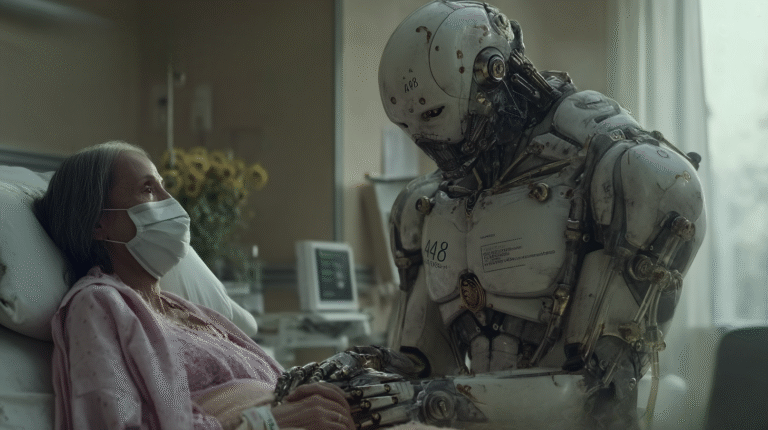

El estudio demostró, además, que este patrón se repite en múltiples idiomas, lo que evidencia que no es un problema de contexto, sino estructural. De ahí que se considere una amenaza sistémica para la adopción global y segura de la IA. El riesgo, en última instancia, no es que la IA alucine, sino que lo haga con tal elegancia que no lo notemos. Esta descalibración entre la certeza interna del modelo y su asertividad lingüística plantea un desafío serio para la fiabilidad de los LLMs en entornos de alto riesgo, como la medicina, la educación o el periodismo.

La calibración importa: de la crítica a la solución con Thermometer

Frente a este desafío, se han empezado a desarrollar soluciones técnicas con capacidad de mitigar la sobreconfianza. Una de las más prometedoras es el método Thermometer, impulsado por investigadores del MIT y el MIT-IBM Watson AI Lab, y del que hablábamos hace unos meses. Thermometer no modifica el modelo principal, sino que añade una capa auxiliar de calibración que ajusta la seguridad con la que se presentan las respuestas, usando técnicas de escalado de temperatura.

Lo notable es que no requiere grandes recursos computacionales ni datos etiquetados para adaptarse a nuevas tareas. En pruebas aplicadas a atención al cliente y generación de contenido, ha demostrado reducir sustancialmente los errores expresados con excesiva seguridad sin afectar la precisión general del modelo. Esta propuesta representa un paso concreto hacia una IA más responsable: una que no solo sea precisa, sino también consciente de sus límites. La calibración, por tanto, no es un extra técnico: es un mecanismo esencial para permitir que el usuario humano recupere su papel de filtro crítico.

Confianza, diseño y responsabilidad: la nueva interfaz del error

La creciente fluidez y capacidad conversacional de los modelos de última generación ha mejorado drásticamente la experiencia del usuario. Hablar con un modelo como GPT-4o es mucho más agradable, más natural, incluso más humano. Pero esta accesibilidad tiene un costo oculto: activa una ilusión de competencia que no siempre está justificada. El tono autoritativo, las respuestas bien estructuradas, el léxico preciso… todo contribuye a generar un aura de fiabilidad. A esto se suma que los modelos más potentes pueden responder de forma fluida incluso cuando están “alucinando”, haciendo que las señales de error sean menos visibles.

Esta situación exige una revisión crítica del diseño de interacción. No basta con exigir más precisión; necesitamos interfaces que comuniquen incertidumbre, que adviertan, que inviten a la verificación. En lugar de invisibilizar los límites del modelo, deberíamos hacerlos explícitos. La inteligencia artificial no debería ser juzgada solo por lo bien que habla, sino por su capacidad para saber cuándo no sabe.

Desconfiar es una forma de cuidar

El uso de IA en procesos creativos, informativos y estratégicos está ya normalizado. Sin embargo, lo que aún no hemos interiorizado es que, incluso en sus versiones más avanzadas, estos sistemas no tienen conciencia de sus errores. Nos toca, entonces, a nosotros —editores, profesionales, usuarios— recuperar el hábito de dudar. Verificar, contrastar, profundizar. No dar por buena una respuesta porque suena bien.

Calibrar la confianza de los modelos no es solo una cuestión de precisión técnica, sino de ética comunicativa. Mientras los desarrolladores avanzan en propuestas como Thermometer, nuestro papel sigue siendo irrenunciable: revisar. Porque la relación con la IA no puede basarse en la fe ciega, sino en un escepticismo informado.