De la voz a la mente: Apple y Meta en la disputa por el próximo punto de entrada

En el tablero global de la tecnología, cada jugador persigue su propio cambio de paradigma. Algunos lo hacen desde posiciones de liderazgo consolidado; otros, desde la necesidad de recuperar terreno. Apple se encuentra en el segundo grupo: busca que la voz sea la próxima interfaz universal, un canal tan natural que sustituya la pantalla como puerta principal a la experiencia digital.

Meta, en cambio, no intenta rediseñar la interacción: prefiere multiplicar los modos de entrar en nuestra esfera más íntima, desde el salón de casa hasta la actividad cerebral. El resultado es una carrera desigual, pero con un objetivo común: apropiarse del primer gesto —o pensamiento— que activa nuestra relación con la tecnología.

Apple: la voz como llave maestra

La nueva generación de Siri, integrada con App Intents, promete ejecutar acciones complejas en aplicaciones sin necesidad de tocarlas. No se trata solo de pedirle el tiempo o enviar un mensaje: hablamos de encadenar operaciones completas, como reservar un vuelo, actualizar un documento de trabajo y compartirlo, todo mediante instrucciones habladas. El diseño voice first que Apple ensaya con iOS 26 y macOS Tahoe 26 no es un experimento marginal: es un intento de colocar la voz en el centro de la experiencia, desplazando al tacto y a la vista como principales interfaces.

En teoría, este cambio ampliaría la accesibilidad, simplificaría flujos de trabajo y liberaría a los usuarios de las pantallas. En la práctica, supone rediseñar por completo el ecosistema de interacción: desde cómo se conciben las aplicaciones hasta cómo se controla la precisión, el error y, sobre todo, la privacidad.

Porque la voz, para funcionar como interfaz principal, exige escuchar de forma continua, incluso cuando no hablamos. En un momento en que otros actores como OpenAI, Google o Amazon llevan años afinando asistentes contextuales, Apple necesita no solo innovar en la experiencia, sino garantizar que su promesa de “privacidad por diseño” resista la tentación de monetizar la escucha.

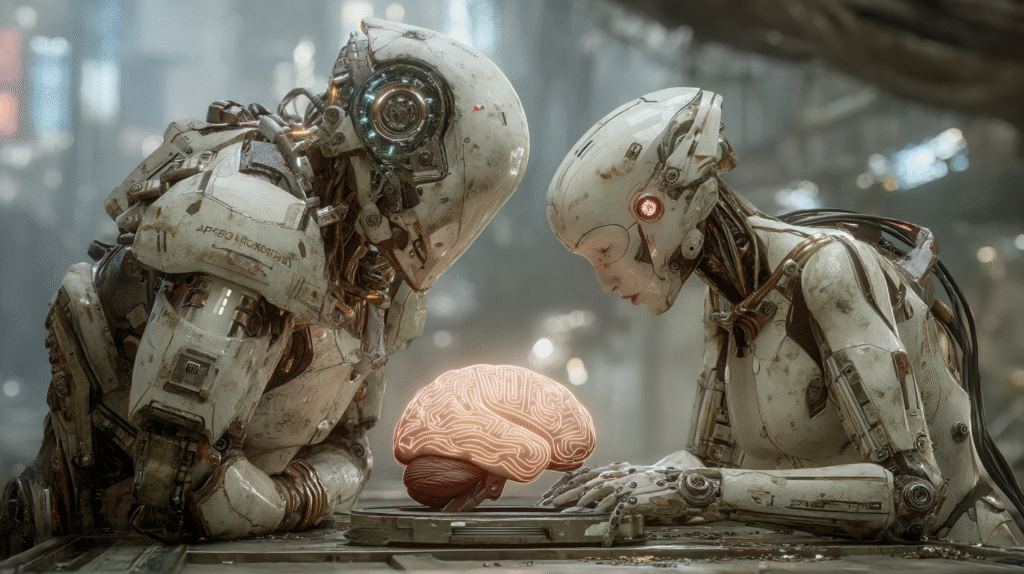

Meta TRIBE: del feed al cerebro

Mientras Apple busca su salto a la siguiente interfaz, Meta trabaja en eliminarla por completo. Su último experimento, TRIBE, es una red neuronal capaz de predecir la activación de regiones cerebrales al ver películas… sin escáner físico. El sistema alcanza un 50 % de acierto combinando análisis de imagen, sonido y lenguaje, y logra la mayor precisión en áreas relacionadas con la atención y la emoción.

El potencial médico es evidente: diagnósticos no invasivos, rehabilitación cognitiva, terapias personalizadas. Pero la historia de Meta sugiere otro uso posible: optimizar, hasta niveles sin precedentes, la capacidad adictiva de sus contenidos. Si hoy ya mide cuánto tiempo miras un vídeo o qué publicaciones te detienen en el feed, mañana podría saber cómo reaccionas antes de que tú seas consciente.

El premio Algonauts 2025 le otorga legitimidad científica, pero también refuerza su imagen como compañía dispuesta a explorar cualquier frontera entre el dato y la intimidad. Meta no quiere que hables con su IA: quiere que su IA anticipe lo que vas a sentir y que actúe en consecuencia.

Dos rutas, un mismo destino

Las estrategias parecen opuestas: Apple quiere ser tu voz; Meta, tu pensamiento. Una persigue la ampliación de la interfaz; la otra, su desaparición. Y, sin embargo, comparten un mismo horizonte: lograr que la interacción sea tan fluida que el usuario olvide que está interactuando. En ese instante, la fricción desaparece… y también la percepción de control.

En el artículo de ayer hablábamos de cómo Grok, Meta, Perplexity y OpenAI exploran distintas vías para monetizar la interacción, desde la publicidad insertada en la conversación hasta la vigilancia emocional o la captura total del contexto digital. Apple y Meta se inscriben en la misma lógica, aunque con herramientas diferentes.

La voz, como la mente, es un recurso de altísimo valor comercial: en ambos casos, hablamos de puntos de entrada que definen no solo la experiencia, sino el acceso a datos con un potencial de explotación inmenso.

El riesgo de la invisibilidad

Cuando la interfaz desaparece —ya sea porque la sustituye la voz o porque se inserta directamente en los patrones cerebrales—, también lo hace la posibilidad de cuestionar cómo opera. El modelo de Apple podría evolucionar hacia un ecosistema donde cada comando hablado se convierta en un registro útil para entrenar modelos de predicción de comportamiento. El de Meta, hacia una plataforma capaz de modelar la experiencia emocional con una precisión que relega la voluntad consciente a un segundo plano.

Ambos caminos plantean un dilema similar al de la monetización conversacional: ¿puede existir una explotación comercial transparente de algo tan íntimo como la voz o la mente? ¿O la mera apertura de ese canal convierte la relación usuario-tecnología en una negociación desigual por definición?

Entre la promesa y la captura

La “voz total” de Apple podría representar un avance real en accesibilidad y productividad. TRIBE, de Meta, podría revolucionar la medicina y abrir nuevas vías para la neurociencia. Pero en un mercado donde el valor de la innovación se mide también por su potencial de monetización, la frontera entre beneficio social y captura intensiva se vuelve difusa.

Al final, lo que está en juego no es solo qué tecnología dominará la próxima década, sino quién controlará el primer impulso de nuestra interacción con el mundo digital. Si ayer la disputa era por la conversación, hoy se expande hacia la voz y la mente. Y quizá la pregunta más urgente no sea cuál de estos dos caminos ganará, sino qué parte de nosotros estamos dispuestos a entregar para que funcionen.