Cuando el modelo del mes ya no convence

La industria de la inteligencia artificial ha vivido años (y meses) de vértigo. El relato dominante sostenía que cada incremento de cómputo, cada ampliación del conjunto de datos y cada capa añadida nos acercaba un paso más al salto cualitativo. Ese discurso ya no se sostiene con la misma convicción. No porque falten avances, sino porque la propia industria empieza a dudar de que el escalado siga siendo la brújula correcta. Lo que viene ahora no es una carrera por multiplicar parámetros, sino una fase más incómoda: investigar con paciencia, asumir límites y aceptar que el progreso profundo exige otro ritmo.

La grieta en el mito del escalado

Durante años, los laboratorios han vendido la idea de que la diferencia entre un modelo y el siguiente residía en su tamaño. La narrativa del “más es mejor” funcionó mientras cada salto parecía confirmar la promesa. Pero la curva ya no sube como antes. Equipos enteros reconocen en privado que duplicar parámetros solo produce mejoras marginales y que hay competencias humanas (transferencia, interpretación, abstracción) que no responden a fuerza bruta. Lo relevante no es que esto ocurra, sino que la crítica ya surge desde dentro: arquitectos del escalado que señalan sus límites, investigadores que perciben la fatiga del paradigma y organizaciones que se fragmentan buscando otra vía.

El mito no cae de golpe; se desgasta. La presión por sostenerlo genera estrategias defensivas: ciclos de actualización más rápidos, anuncios superlativos, versiones que “reinventan” modelos recién presentados. La saturación no es técnica. Es narrativa.

Investigación a puerta cerrada y espectáculo a puerta abierta

Aquí emerge una tensión que atraviesa todo el sector: la diferencia entre investigar y ensamblar. La industria confunde ambos planos y lo hace con intención. La investigación ocurre en silencio, requiere espacio para equivocarse y produce resultados que no siempre justifican un comunicado. Lo que vemos en público es otra cosa: flujos de trabajo que extienden arquitecturas sin replantearlas, demos que maquillan límites profundos y promesas de revolución que caducan en semanas.

El rebranding del “avance incremental” como “nuevo paradigma” crea una ilusión de aceleración continua. Funciona como mecanismo de defensa frente al reconocimiento de que aún no sabemos cómo construir modelos que aprendan con la eficiencia de un niño, que generalicen fuera de su dominio o que razonen sin apoyo estadístico. El espectáculo oculta la pausa. Pero sin pausa no hay ciencia.

Laboratorios que rompen con la coreografía

La fragmentación de grandes laboratorios se ha contado como movimiento empresarial, pero es más profunda. Equipos que participaron en la edad del escalado abandonan esa lógica para explorar arquitecturas más trazables, modulares y gobernables. La aparición de nuevos centros (algunos con raíces comunes, otros con vocación divergente) no es casual: refleja una necesidad de recuperar autonomía científica frente a la agenda de producto.

Estos espacios buscan una IA que no dependa de ciclos trimestrales, que no viva condicionada por la exhibición permanente y que no confunda capacidad con opacidad. Prefieren la experimentación lenta, la reformulación conceptual y el diseño orientado al control humano antes que a la espectacularidad. Ese movimiento todavía es pequeño, pero su sola existencia evidencia que el escalado como único método ya no aglutina consensos.

El límite económico del conocimiento profundo

La investigación real no es barata. La separación creciente entre modelos de élite (costosos, complejos y difíciles de reproducir) y modelos accesibles (erráticos, superficiales) dibuja un patrón que la industria evita reconocer. Si los sistemas que prometen sustituir tareas de alta especialización requieren cuotas mensuales comparables al salario de un técnico cualificado, la conclusión es simple: no están listos para reemplazar nada, y quizá nunca lo estén en los términos en que se ha contado.

El coste es una señal de fragilidad, no de potencia. La “IA barata” produce ruido, saturación documental y errores difíciles de rastrear. La “IA cara” es una herramienta de nicho cuya viabilidad depende de un capital que exige impacto inmediato. En ambos casos, la ciencia profunda queda en tierra de nadie: demasiado lenta para el mercado, demasiado cara para democratizar, demasiado compleja para presentar como producto semanal.

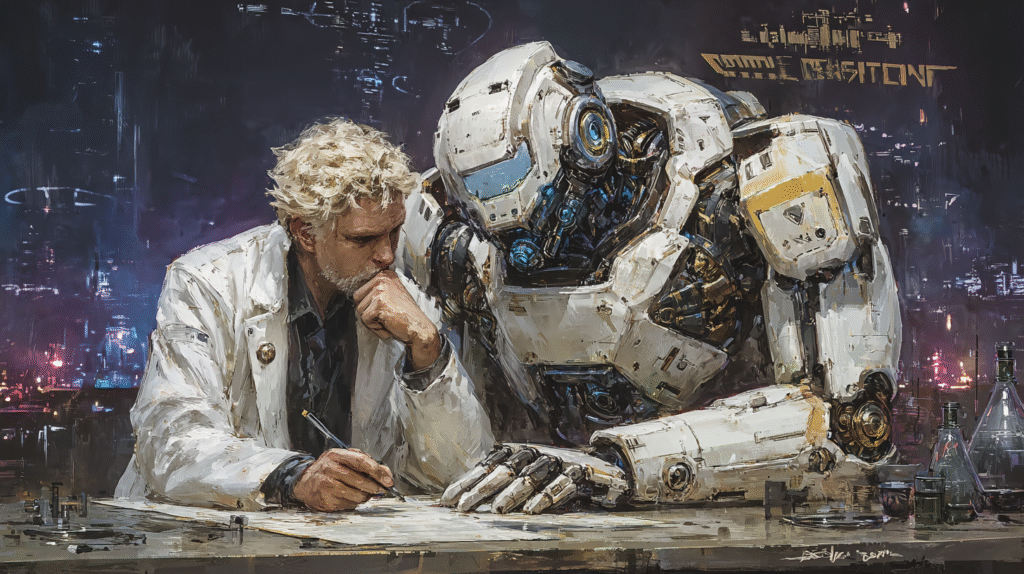

Ética como estructura, no como eslogan

Cuando algunos laboratorios hablan de “cuidar la vida sintiente” o de construir IA “para el bien”, el riesgo es que esas ideas se conviertan en frases que acompañan al lanzamiento de un producto. Pero hay un movimiento emergente, todavía minoritario, que sitúa la ética en el diseño: trazabilidad, auditabilidad, modularidad, espacios donde la IA no sustituye decisiones críticas, sino que las acompaña.

Aquí la ética no es relato. Es criterio técnico: qué se permite optimizar, qué se prohíbe automatizar, qué nivel de opacidad es inaceptable, qué tipo de errores una organización no puede tolerar. La edad de investigación obligará a definir estos límites no como declaraciones públicas, sino como condiciones operativas de los modelos.

Un futuro que requiere otro ritmo

Si algo comparten los síntomas actuales (agotamiento del escalado, fragmentación institucional, precios prohibitivos, saturación de ruido, presión por exhibir avances) es que todos señalan un cambio de fase. La edad de investigación será menos vistosa y más exigente. No recompensará la velocidad. No permitirá atajos. Y no encajará con quienes dependan de anunciar prodigios cada dos meses.

Las evidencias muestra llevan a la industria a admitir que no basta con mover más datos ni multiplicar cómputo. Lo que viene exige otra forma de entender qué significa aprender. No es una meta clara ni un destino garantizado. Es un territorio que se abre solo cuando dejamos de correr lo bastante como para mirarlo.