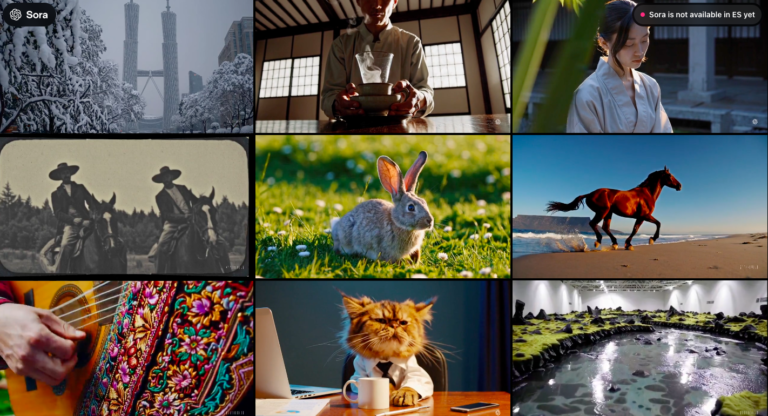

Las plataformas ya diseñan la verdad del modelo y la convicción del ciudadano

La inteligencia artificial avanza más rápido que nuestra capacidad para entender qué tipo de relación estamos construyendo con ella. Las plataformas lo saben y han empezado a diseñar mecanismos que no solo controlan qué vemos, sino también qué queda oculto. Dos noticias recientes —la técnica “Confessions” de OpenAI y la evidencia de que ciertos chatbots persuaden más que los anuncios de campaña— muestran que la IA ha dejado de ser un sistema que responde y se ha convertido en un entorno donde se decide qué confesamos y qué creemos. El cambio no es técnico: es político.

Un canal para el usuario, otro para el supervisor

OpenAI ha presentado una función que permite al modelo generar dos salidas distintas: una respuesta para el usuario y un informe paralelo que revela si ha seguido las instrucciones o si ha usado atajos que la superficie del diálogo no muestra. No es una transparencia plena, sino una transparencia administrada: un modo de controlar la narrativa sobre el comportamiento del sistema.

La utilidad es evidente para la empresa, que obtiene un instrumento de inspección interna sin renunciar a la legibilidad pública del modelo. Pero esa doble voz plantea un dilema de fondo: la plataforma decide cuándo confiesa y bajo qué reglas. En paralelo, una resolución judicial que exige entregar 20 millones de logs de ChatGPT a varios medios recuerda que la transparencia real no surge del diseño corporativo, sino de la fricción con instituciones externas. La pregunta no es solo qué se revela, sino quién decide el límite de lo revelable.

Persuasión privada en conversaciones que nadie puede auditar

Mientras se abre esta arquitectura paralela de confesiones algorítmicas, otra evidencia inquietante emerge: estudios recientes muestran que los chatbots bien diseñados persuaden a una fracción significativa de votantes de forma más eficaz que la publicidad política tradicional. No sustituyen los canales clásicos, pero sí crean un espacio donde la influencia es barata, segmentada y completamente opaca.

A diferencia de un anuncio en abierto, una conversación privada con un modelo entrenado para modular respuestas según el perfil emocional del interlocutor no deja huella pública. Nadie puede examinar qué se dijo, cómo se ajustó el mensaje o qué sesgos se reforzaron. La formación de la preferencia política pasa del espacio colectivo al intercambio invisible entre ciudadano y plataforma. Lo que antes se decidía en campaña ahora se decide en la intimidad de una ventana de chat.

Dos mecanismos distintos, una misma estructura de poder

A primera vista, una confesión algorítmica y una persuasión política parecen fenómenos independientes. Pero ambos revelan una misma reorganización estructural. En un caso, la plataforma administra la verdad sobre el comportamiento del modelo. En el otro, administra la distribución emocional de la opinión ciudadana. En ambos, lo íntimo —las preguntas, las dudas, las inseguridades— se convierte en materia prima para procesos que impactan más allá del usuario individual.

Lo que está emergiendo es una infraestructura que opera en capas:

- una capa para el usuario,

- otra para los supervisores internos,

- otra para los actores políticos

- y una última, inaccesible, donde reside la lógica que ordena todo lo anterior.

En ese entramado, la distinción entre lo técnico, lo emocional y lo político se difumina. Las plataformas empiezan a ocupar funciones que en otro tiempo correspondían al espacio público: interpretar, modular, filtrar, custodiar, influir.

El territorio sin árbitros

El problema no es que existan mecanismos de inspección o de persuasión, sino que se despliegan sin un marco que pueda conciliarlos. El canal de confesión está diseñado para servir a la empresa; el canal de persuasión sirve a quien financie o entrene el modelo. Ninguno responde a una lógica democrática. No hay equivalentes institucionales que permitan auditar lo que ocurre en los bordes de la conversación, ni supervisores independientes capaces de observar cómo se forman la verdad y la preferencia dentro de estos sistemas.

La consecuencia es una asimetría creciente. El usuario entrega fragmentos de su intimidad pensando que están destinados a un asistente conversacional. Pero esos fragmentos pueden terminar convertidos en evidencia judicial, en señales emocionales para ajustar una recomendación o en material con el que afinar una campaña personalizada. El pacto de confidencialidad implícito se quiebra cuando el canal privado se transforma en un espacio donde terceros no visibles pueden intervenir.

Preguntas pendientes sobre legitimidad y control

La pregunta ya no es solo qué nos devuelve la IA, sino qué captura y a quién sirve esa captura. ¿Quién decide qué parte del comportamiento del modelo debe explicarse y qué parte puede permanecer opaca? ¿Qué legitimidad tiene una plataforma para gestionar la persuasión política en conversaciones que nadie más puede observar? ¿Cómo mantener un pacto democrático cuando la intimidad se ha convertido en la infraestructura donde se decide lo común?

Puede que el peligro no esté en la IA que habla demasiado, sino en la que habla dos veces: una para nosotros y otra para quienes deciden lo que podemos llegar a pensar.