La web se llena de ecos y la calle de máquinas

La expansión reciente de la inteligencia artificial ha generado un efecto curioso: cuanto más avanza, menos claro resulta el orden de prioridades que guía su desarrollo. Saltamos de una novedad a otra con entusiasmo casi automático, mientras la base que debería sostener cada salto llega tarde. No es una crisis de capacidad, sino de ritmo. Y ese desfase se manifiesta en tres frentes que ya no pueden separarse: la complejidad creciente de los sistemas, la llegada de la IA al mundo físico y el cansancio cultural ante una web saturada de texto sintético.

La inteligencia sin cimientos

Llevamos dos años, especialmente este 2025, en el que la discusión gira en torno a quién tiene el modelo más grande. Esa obsesión empieza a perder sentido justo cuando emerge la capa que de verdad define el poder del sistema: la orquestación. Decidir qué modelo interviene, qué herramienta se activa y cuándo conviene razonar o delegar se ha vuelto más relevante que la fuerza bruta del parámetro. NVIDIA apunta a ese giro silencioso: la inteligencia ya no reside solo en generar, sino en coordinar.

Pero cada capa nueva trae su propia sombra. Con sistemas que delegan acciones, comparan resultados y toman decisiones encadenadas, la trazabilidad se convierte en un acto de fe. No porque falte técnica, sino porque todo sucede demasiado deprisa para auditar cada detour del proceso. Ese incremento de complejidad remite directamente a algo que ya hemos comentado aquí, y es que la autonomía crece más rápido que la capacidad real de supervisarla. El resultado es un impuesto constante, pagado en tiempo, incertidumbre y vigilancia manual. La IA simplifica tareas, sí, pero cada intento de que opere sola abre un nuevo punto ciego que alguien tendrá que revisar más tarde.

Esta fragmentación de la responsabilidad no es un fallo marginal; es el signo de una arquitectura que aún no está preparada para sostener el sistema que estamos construyendo sobre ella. Y, sin embargo, seguimos añadiendo capas.

Cuando la IA actúa sin red

El salto del texto a la acción física acentúa el desajuste. Robotaxis que siguen dependiendo de un operador en la sombra, humanoides que se prueban en entornos industriales más por ambición que por madurez tecnológica, o gafas que registran lo que miramos antes de que exista un marco claro sobre cómo se procesan esos datos

La narrativa pública insiste en que la autonomía está a la vuelta de la esquina, pero los despliegues reales muestran otra historia. No fallan por falta de potencia, sino por ausencia de condiciones: calles pensadas para humanos, normas que no contemplan decisiones máquina a máquina, empresas que confían en la repetición más que en el contexto. Aquí la tecnología tropieza con el suelo cultural y regulatorio, y ese choque revela algo más profundo. Una IA que actúa sin red convierte cualquier error en riesgo compartido.

Cuando una decisión automatizada depende de fuentes inciertas o se despliega en entornos sin defensas adecuadas, su impacto no se limita a un fallo puntual. Puede trasladarse a la economía, a los servicios públicos, a la gestión urbana. Un robot que tropieza es un accidente. Un agente autónomo que reacciona mal ante un contexto confuso es una fisura. La diferencia entre ambas cosas depende de si el sistema tiene cimientos, no de la potencia del modelo.

La saturación sintética y la búsqueda de claridad

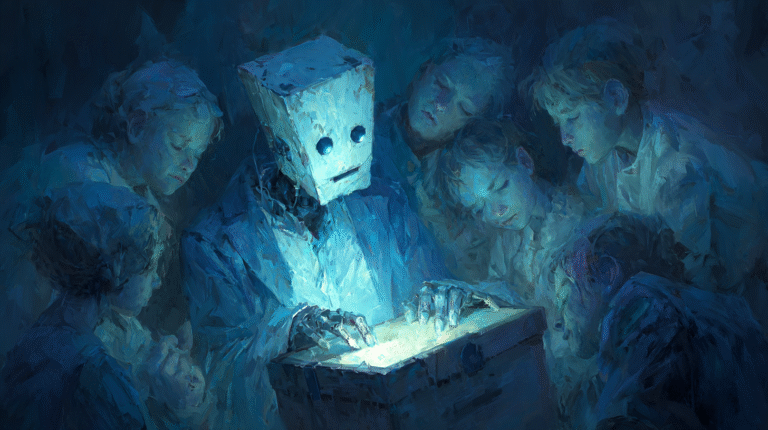

En paralelo a la escalada técnica y al avance físico, la web atraviesa una transformación más silenciosa: el cansancio ante el exceso de contenido generado por IA. No hablo solo de textos pobres, sino de la sensación de que la superficie digital se ha vuelto repetitiva hasta deformar el juicio. Como muestra un síntoma claro: la demanda de herramientas que filtren, congelen o retrocedan la web para recuperar un punto en el que la procedencia aún podía inferirse sin esfuerzo.

Como apuntaba hace unos meses, la degradación de la experiencia en línea no surge de un modelo concreto, sino de un sistema que prioriza volumen sobre criterio. Si la IA acelera esa saturación, es lógico que los usuarios reaccionen buscando modos de contención. Una web capaz de generar millones de variaciones de lo mismo produce la paradoja de la abundancia vacía. A mayor oferta, menor claridad. Y la confianza se erosiona no por un hecho aislado, sino por acumulación.

El movimiento hacia la “higiene digital” no expresa nostalgia; expresa supervivencia cognitiva. Cuando la densidad sintética aumenta, filtramos para volver a ver.

El péndulo de la confianza

Los tres frentes —complejidad interna, presencia física y saturación digital— comparten un hilo común: todos avanzan más rápido de lo que la infraestructura humana y técnica puede absorber. Y cuando esa brecha se abre, la reacción no adopta la forma de rechazo al progreso, sino de construcción de barreras.

Barreras técnicas: orquestadores más exigentes, auditorías, trazabilidad.

Barreras regulatorias: moratorias, restricciones de uso, limitación de despliegues.

Barreras culturales: filtros, retrocesos temporales, escepticismo organizado.

Lo que desde fuera parece freno, desde dentro es un intento del sistema de recuperar equilibrio. Tal vez porque la IA puede contribuir a mejorar el ecosistema digital solo si el entorno donde opera sostiene un mínimo de orden. Y ese orden no se garantiza solo con ingeniería; requiere priorizar antes de escalar.

Las tecnologías no se detienen por decreto, pero sí pueden ralentizarse por falta de confianza. Y esa confianza, cuando se pierde, tarda mucho más en regresar que en evaporarse.

Una pausa para reconstruir el suelo

No vivimos una crisis de inteligencia artificial. Vivimos una crisis de prioridades. La IA seguirá avanzando, a veces demasiado deprisa, pero el reto no está en domar la velocidad, sino en reconstruir el suelo que la sostiene. Quizá la pausa no sea un gesto conservador, sino el único modo de garantizar que la próxima capa no se convierta en otro punto ciego.

El ritmo puede seguir, pero el suelo tiene que alcanzarlo alguna vez.