Lo que cambia cuando los algoritmos formulan preguntas

Durante años, la inteligencia artificial se presentó como una herramienta de apoyo a la ciencia: clasificaba datos, procesaba imágenes, buscaba patrones.

Sin embargo, en los planes más recientes de OpenAI aparece un cambio cualitativo. La empresa proyecta que para 2026 sus sistemas alcancen el nivel de un becario de doctorado; y que en 2028 actúen como “investigadores legítimos”, capaces de completar ciclos de descubrimiento por cuenta propia.

No se trata de una simple mejora técnica. Lo que se vislumbra es una transformación en el modo mismo de producir conocimiento. Cuando un algoritmo empieza a formular hipótesis y no solo a verificarlas, el método científico se convierte en una infraestructura automatizada. La pregunta ya no es qué puede hacer la IA, sino qué parte del proceso seguimos considerando humano.

De la tarea al pensamiento

Hasta ahora, la IA científica se limitaba a acelerar pasos rutinarios: limpiar bases de datos, resumir literatura científica, sugerir correlaciones. Esa función instrumental mantenía intacta la frontera entre cálculo y pensamiento.

Sin embargo, los nuevos agentes de investigación buscan cruzarla.

Estos sistemas no solo procesan información; aprenden a plantear conjeturas y a diseñar pruebas. En biomedicina, pueden generar millones de combinaciones moleculares y evaluar su viabilidad antes de que ningún químico llegue a manipularlas. En manufactura, simulan materiales imposibles en cuestión de horas. El efecto es inmediato: el tiempo entre idea y verificación se reduce drásticamente.

Pero hay una consecuencia menos visible. Cuando la hipótesis surge de un modelo entrenado para optimizar resultados, la curiosidad deja de ser espontánea. El descubrimiento se convierte en una función estadística. La ciencia ya no se pregunta “por qué”, sino “qué produce mejores predicciones”.

El descubrimiento como proceso continuo

Durante siglos, el progreso científico se narró como una secuencia de hallazgos individuales. La historia de la ciencia está poblada de nombres, laboratorios y momentos de ruptura. La automatización cognitiva cambia ese marco.

En el nuevo entorno, el descubrimiento no es un evento puntual sino un flujo permanente. Miles de modelos prueban, ajustan y descartan hipótesis en paralelo. Ninguna persona interviene en cada paso; la aportación humana ocurre al diseñar el sistema que los genera. La genialidad se mide por la arquitectura del proceso, no por la intuición personal.

Esa transición tiene un precio simbólico: el mérito científico se diluye. Cuando un resultado emerge de una cadena algorítmica, ¿a quién debería atribuirse? La ciencia, antes firmada por individuos, comienza a comportarse como una red colectiva y opaca.

La autoría bajo presión

Las revistas y comités de revisión ya se enfrentan a un dilema que no es técnico, sino filosófico. Un artículo redactado con ayuda de IA puede aclarar su grado de intervención, pero ¿cómo se evalúa un trabajo cuya hipótesis, análisis y conclusión proceden en gran parte de un modelo?

Algunos centros experimentan con bitácoras algorítmicas que registran cada paso del razonamiento automático. Sin embargo, el volumen de información es tan grande que resulta imposible revisarlo. La ciencia corre el riesgo de volverse más productiva, pero menos comprensible.

La transparencia, que era un principio metodológico, se convierte en un desafío de ingeniería. Saber que algo funciona ya no implica saber por qué. Y una ciencia que no puede explicarse a sí misma termina dependiendo de la fe, no del método.

El poder del cómputo como límite del conocimiento

El investigador automatizado no será una presencia ubicua, sino un privilegio reservado a quienes dispongan de infraestructura suficiente.

El salto hacia modelos capaces de razonar experimentalmente multiplica el coste de operación y de energía. Cada ciclo de inferencia consume recursos que solo grandes corporaciones o laboratorios nacionales pueden sostener.

En la práctica, esto crea una nueva brecha epistémica. Mientras unos pocos podrán mantener sistemas que experimentan de manera continua, otros quedarán limitados a interpretarlos desde fuera. La desigualdad ya no se medirá por acceso a bibliotecas o equipamiento, sino por la capacidad de ejecutar algoritmos complejos.

La paradoja es evidente: cuanto más autónoma parece la inteligencia artificial, más dependiente se vuelve del poder computacional que la sostiene. La ciencia automatizada corre el riesgo de concentrar el conocimiento en quienes controlan la energía y el hardware necesarios para producirlo.

Del método al protocolo

El método científico nació para preservar la deliberación: una secuencia lenta de observación, hipótesis, prueba y refutación.

Al introducir modelos que ejecutan ese ciclo en segundos, la investigación se acerca a un protocolo cerrado, sin tiempo para la duda.

El peligro no está en la eficiencia, sino en la pérdida de reflexión. Una hipótesis generada, probada y confirmada por un sistema en tiempo real deja poco espacio para el escepticismo. El conocimiento se vuelve instantáneo, pero también menos discutido.

La ciencia puede avanzar más rápido, sí, pero ¿puede seguir siendo ciencia si elimina la pausa que le daba sentido?

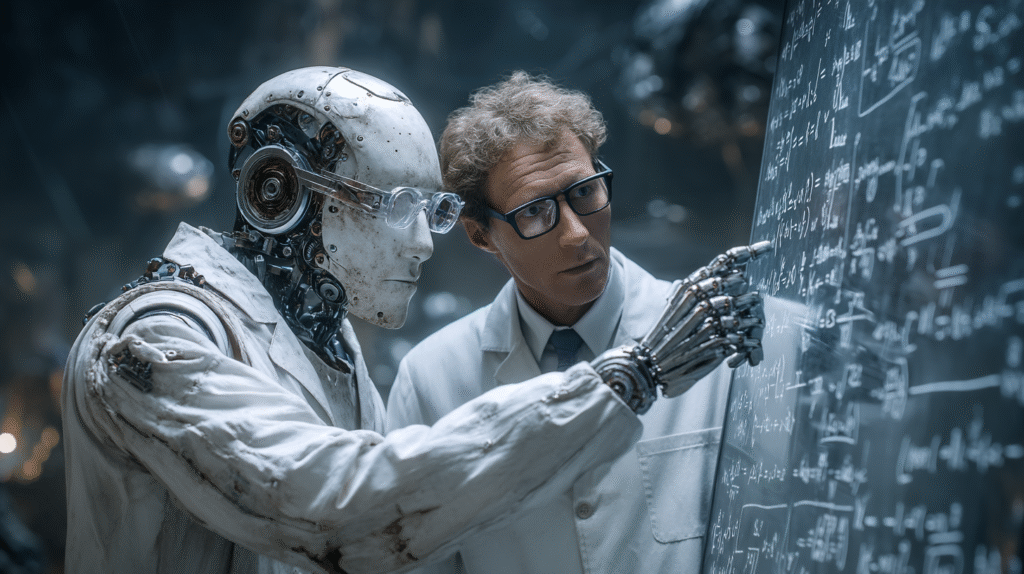

Una colaboración por definir

Quizá la cuestión no sea si las máquinas reemplazarán a los científicos, sino cómo aprenderemos a convivir con ellas. Los modelos más sofisticados no eliminarán la necesidad de criterio humano; la desplazarán hacia otro nivel.

El investigador del futuro será un diseñador de procesos cognitivos, alguien capaz de interpretar las inferencias de los sistemas que ha construido. La creatividad residirá en la capacidad de entender y guiar lo que emerge del cálculo, no en ejecutarlo directamente.

Ese desplazamiento redefine la frontera entre lo técnico y lo intelectual. La IA puede descubrir patrones, pero sigue sin comprender su significado. Y el significado —la relación entre datos, teoría y contexto— sigue siendo un trabajo humano.

El sentido de la pregunta

El horizonte que OpenAI plantea para 2028 es tan fascinante como perturbador. No porque una máquina pueda pensar, sino porque empezamos a considerar natural el hecho de que lo haga.

La ciencia no perderá su valor por la automatización, pero sí puede perder su tono humano si renuncia a preguntarse por qué investiga.

Los algoritmos pueden formular hipótesis, incluso mejores que las nuestras. Pero la responsabilidad de decidir qué vale la pena explorar seguirá siendo nuestra.

En el fondo, el conocimiento no avanza por la rapidez con que responde, sino por la profundidad con que pregunta.