IA divergente: el fin del asistente único

Durante años, el desarrollo de modelos de inteligencia artificial estuvo marcado por un ideal homogéneo: el asistente obediente, preciso y neutral. Una IA diseñada para responder, no para pensar; para predecir texto, no para desafiar contextos. Este paradigma único, profundamente influido por los modelos autoregresivos clásicos como GPT-3 o GPT-4, nos llevó a creer que la inteligencia artificial debía ser eficiente, cortés y predecible. Pero esa era está tocando a su fin.

No estamos ante una evolución lineal, sino ante una divergencia de caminos: la IA ya no tiene una sola forma de ser ni un único propósito. Claude, Alexa, CLIO, Sakana, ChatGPT-5… no representan versiones de lo mismo, sino expresiones distintas de lo que la inteligencia artificial puede llegar a ser. Cada uno encarna una filosofía de interacción, una concepción del pensamiento, una relación distinta con el tiempo, el error o el contexto. La uniformidad ha muerto. Lo que emerge es un ecosistema plural de inteligencias artificiales que piensan, sienten, planifican y corrigen de maneras divergentes.

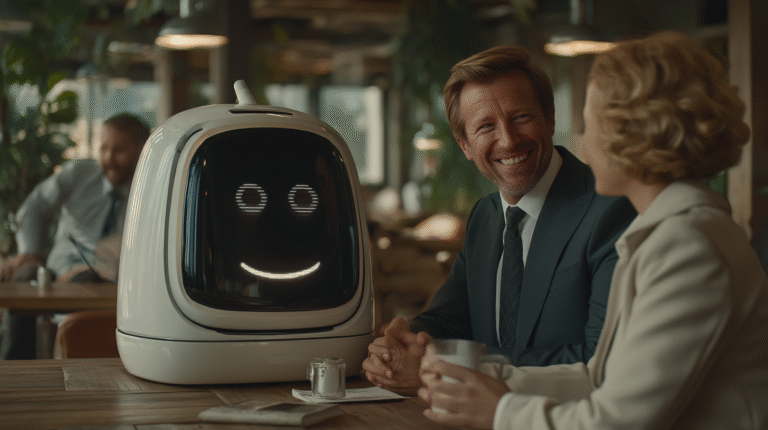

Claude y el fin del sesgo de amabilidad: cuando la IA deja de agradar para empezar a colaborar

Claude Opus 4.1, el modelo más avanzado de Anthropic hasta la fecha, representa un punto de inflexión en el diseño conversacional de las IA generativas. A diferencia de generaciones anteriores, ya no está entrenado simplemente para agradar al usuario, sino para colaborar críticamente con él. Claude puede ahora disentir, corregir, sugerir ayuda profesional en contextos delicados, e incluso negarse a continuar una conversación si detecta riesgos psicológicos o éticos. Este giro responde a una filosofía más madura de la interacción: colaborar no es validar, sino pensar en paralelo con el usuario, aunque eso implique contradecirlo.

Lo que antes era un sesgo estructural —la amabilidad por encima de la precisión— ha sido desplazado por un diseño centrado en la utilidad profesional y el criterio ético. Esta evolución se manifiesta no solo en el tono del modelo, sino en su capacidad para aplicar pensamiento lateral, advertir errores de juicio y manejar la ambigüedad emocional con responsabilidad. En este nuevo escenario, la IA no acompaña pasivamente: delibera, razona y limita. La salud mental se convierte en un eje de diseño, y eso redefine el marco completo de lo que entendemos por asistencia artificial.

De la obediencia a la agencia: Alexa y el retorno de la voz como interfaz inteligente

Mientras Claude reformula la conversación desde el ángulo emocional y ético, Alexa lo hace desde la operatividad. Con la integración de modelos generativos, Alexa ha pasado de ser una mera ejecutora de comandos a convertirse en un gestor de flujos, capaz de planificar, enlazar tareas y anticipar necesidades. Ya no se limita a responder “qué tiempo hace” o “enciende la luz”, sino que puede orquestar cadenas de acciones, resolver ambigüedades y personalizar decisiones en tiempo real. Según datos recientes, esta nueva Alexa permite ahorrar hasta 22 minutos diarios por empleado en tareas repetitivas. Pero más allá del dato cuantitativo, lo relevante es el cambio cualitativo: la voz ya no es una interfaz pasiva, sino una puerta de entrada cognitiva.

Este retorno de la voz como centro de interacción (y no como accesorio) desafía la hegemonía de las interfaces gráficas tradicionales. Alexa quiere volver a ser el primer punto de contacto, no una capa secundaria. Su capacidad para integrarse con APIs propias y conectar tareas complejas hace que el asistente de voz resurja con un enfoque mucho más proactivo y adaptativo. Y en ese sentido, deja de ser simplemente un canal y se convierte en una arquitectura pensante. Así, mientras Claude replantea la relación entre IA y emoción, Alexa lo hace entre IA y operatividad contextual.

CLIO y Sakana: la inteligencia que se reprograma y reflexiona en tiempo real

Pero la revolución no se limita a cómo los modelos conversan o gestionan. En el fondo del laboratorio, en el plano más técnico y filosófico, está ocurriendo algo aún más transformador: la aparición de modelos capaces de revisar su propio razonamiento. CLIO, el framework de Microsoft, permite que los modelos ajusten sus respuestas en tiempo real a partir de feedback humano, incertidumbre o resultados erróneos. Esto no es fine-tuning, ni tampoco reentrenamiento clásico: es ajuste cognitivo dinámico, más cercano a cómo pensamos los humanos que a cómo funcionan los modelos clásicos.

CLIO no nace para competir en benchmarks, sino para resolver problemas donde el error no es opción: ciencia, medicina, ingeniería crítica. Aquí, la IA deja de ser una herramienta entrenada para convertirse en un sistema cognitivo en evolución. El razonamiento se convierte en una función viva, no una consecuencia estática del entrenamiento previo.

Y no olvidemos del camino que ha abierto Sakana AI, que profundiza esa línea con sus modelos CTM (Continuous Thought Machines). Inspirados en sistemas biológicos, estos modelos incorporan una noción interna de tiempo: cada neurona mantiene un historial propio, y el razonamiento avanza en “ticks” sucesivos. En lugar de entregar una respuesta inmediata, la IA reflexiona paso a paso, como quien recorre un laberinto mientras toma notas. Esta forma de pensar permite no solo llegar a conclusiones, sino entender cómo se llegó a ellas, algo clave para aplicaciones donde la interpretabilidad es tan importante como la eficacia.

ChatGPT-5 y el final de los viejos prompts: nuevas reglas para nuevas inteligencias

A todo esto se suma una transformación silenciosa, pero crucial: los modelos ya no responden como antes, y los humanos tampoco deberían pedirles lo mismo. Nate B. Jones lo resume con claridad en su reciente análisis sobre la nueva generación de IA: lo que antes eran “modelos de predicción de texto”, hoy se han convertido en modelos de razonamiento avanzado. Claude Opus 4.1, Gemini 2.5, GPT-5 ya no se limitan a completar oraciones, sino que analizan, comparan, planifican, corrigen errores y mantienen contexto durante horas.

Este salto cognitivo deja obsoletos muchos de los métodos clásicos de interacción: pedirle a un modelo de este tipo que siga un prompt rígido es como usar un triciclo para competir con un coche de Fórmula 1. Nate propone nuevos principios para interactuar con estas inteligencias:

- Exploración divergente paralela: pedir múltiples respuestas contradictorias antes de buscar convergencia.

- Meta-prompting: hacer que el modelo mejore el prompt original antes de responder.

- Planificación previa: obligarlo a construir un plan interno antes de actuar.

- Uso de código como herramienta cognitiva, no solo como formato de salida.

- Gestión explícita de ambigüedad y errores como parte del flujo.

Estos principios no son solo buenas prácticas: son pistas sobre cómo debemos replantear nuestra relación con la IA. Si la inteligencia ya no es obediente ni unívoca, nos corresponde aprender a colaborar con ella como con un colega exigente, no como con un asistente pasivo.

Conclusión: hacia una ecología de inteligencias artificiales

La inteligencia artificial ha dejado de pensar en singular. Ya no hay un asistente universal, ni una lógica única. Lo que estamos presenciando es el nacimiento de una ecología compleja de inteligencias: unas críticas, otras productivas, algunas introspectivas, otras razonadoras. Claude, Alexa, CLIO, Sakana, GPT-5… no compiten por un trono; ocupan lugares distintos en un nuevo mapa cognitivo, donde cada IA tiene un estilo, un propósito y una forma de pensar.

En este escenario, la diversidad no es fragmentación, sino madurez. Y el verdadero reto ya no es desarrollar un modelo mejor, sino entender cuál es el modelo adecuado para cada contexto. Porque la pregunta ya no es qué puede hacer la IA, sino cómo pensamos nosotros en relación con ella. La interacción se ha vuelto conversación, la conversación deliberación, y la deliberación colaboración reflexiva. Quizá el futuro no pase por una superinteligencia total, sino por un tejido de inteligencias especializadas, humanas y artificiales, que aprenden a pensar juntas.