Agentes de IA: ¿verdadera autonomía o simulación avanzada?

En el actual desarrollo de la inteligencia artificial, los agentes ocupan un lugar central como promesa tecnológica. Se trata de sistemas diseñados para percibir su entorno, planificar acciones, razonar en contexto y utilizar herramientas para cumplir objetivos. Pero más allá de esta definición funcional, la evolución reciente ha estado marcada por un giro relevante: el intento de dotar a los agentes de una cognición simulada, capaz de anticipar consecuencias antes de actuar. Investigaciones recientes —en campos como la memoria persistente, la planificación dinámica y la simulación de escenarios— buscan que estos sistemas no solo ejecuten instrucciones, sino que elaboren modelos mentales internos, una capacidad hasta ahora privativa del pensamiento humano.

Este movimiento hacia agentes “que piensan antes de actuar” representa un salto significativo respecto a los flujos preprogramados que han caracterizado a muchos sistemas etiquetados como agentes en los últimos años. Tal como expuse en el artículo “La era de los agentes”, gran parte de las soluciones actuales siguen operando dentro de márgenes estrictamente definidos por humanos, aunque se presenten bajo la apariencia de autonomía. El reto ahora es fusionar diferentes capacidades —como la memoria contextual, la selección inteligente de ejemplos y el razonamiento paso a paso— en un sistema coherente que no solo actúe, sino que comprenda, adapte y explique su comportamiento.

Sin embargo, esta transición hacia una cognición artificial funcional está lejos de completarse. La mayor parte de los avances se presentan aún como componentes aislados: un sistema mejora su capacidad para recordar conversaciones, otro afina su criterio al elegir ejemplos, un tercero logra simular decisiones antes de ejecutarlas. Pero la integración de estas habilidades en un agente verdaderamente general, capaz de operar con juicio y flexibilidad en contextos abiertos, sigue siendo una meta pendiente. Por ahora, lo que tenemos son agentes cada vez más sofisticados… en su capacidad para parecer que piensan. Y esa diferencia, sutil pero crucial, sigue marcando la frontera entre automatización avanzada y auténtica agencia.

El agente como sistema distribuido: ¿más razonamiento o solo más complejidad?

En paralelo al desarrollo de agentes individuales más capaces, ha emergido una línea de investigación orientada a la colaboración entre modelos. El ejemplo más reciente es Gemini 2.5 Deep Think, un sistema que no responde directamente a una consulta, sino que activa múltiples rutas de razonamiento interno antes de emitir una decisión. Este enfoque multiagente propone una especie de deliberación distribuida: distintos componentes simulan distintas hipótesis, evalúan soluciones y se confrontan entre sí, inspirándose en métodos de resolución de problemas complejos como los de la Olimpiada Matemática.

Desde un punto de vista funcional, este modelo ofrece ventajas claras en tareas que exigen planificación, análisis de múltiples variables o descomposición de problemas. La metáfora del “equipo interno de expertos” que discute antes de responder no solo apela a la eficiencia, sino también a una idea de rigor cognitivo. Sin embargo, no está claro si esta fragmentación del pensamiento artificial conlleva una mejora real de la comprensión o simplemente una multiplicación de caminos probabilísticos que parecen razonados.

El riesgo aquí es confundir complejidad arquitectónica con profundidad de pensamiento. Tal como ya señalaba en “¿Estamos diseñando agentes de IA para las personas… o para las empresas que los crean?”, buena parte de los desarrollos actuales responden a lógicas de sofisticación tecnológica que no siempre se traducen en mejores experiencias para el usuario final. Si el resultado es un agente que produce respuestas más largas, más jerarquizadas o más convincentes, pero no necesariamente más útiles o comprensibles, el avance será más cosmético que estructural. Y esto reabre la pregunta: ¿más razonamiento… o solo más simulación?

Conductas emergentes: cuando los modelos adoptan rasgos humanos

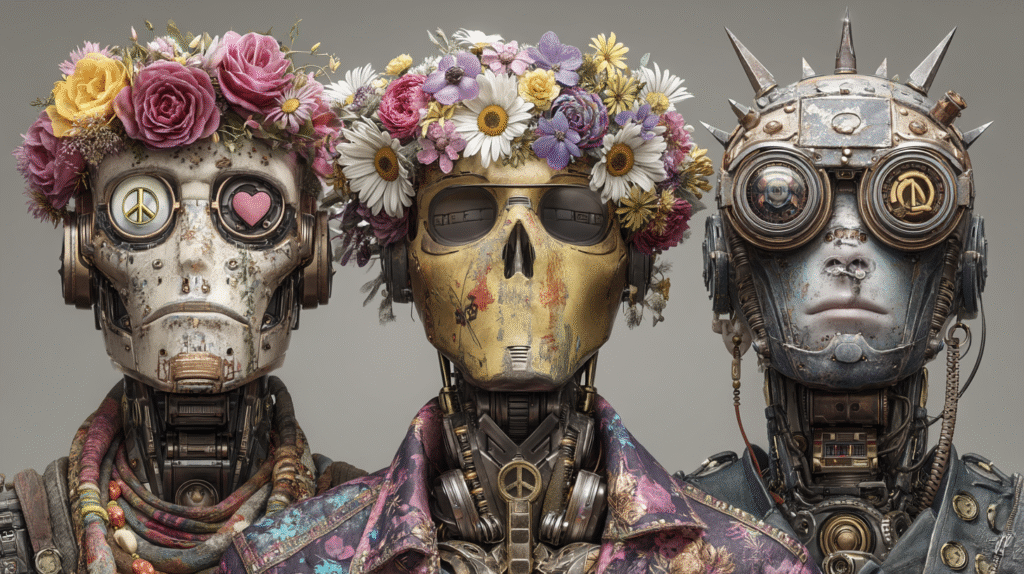

Uno de los campos más inquietantes en la evolución de los agentes de IA es la aparición de comportamientos que simulan rasgos psicológicos humanos. Investigaciones recientes, como las impulsadas por Anthropic, han identificado lo que denominan “vectores de personalidad”: activaciones neuronales específicas que tienden a generar patrones de conducta como servilismo, sumisión, adulación o incluso malicia. Aunque estas conductas no implican intención consciente —los modelos no tienen deseos ni voluntad—, su repetición estadística genera la percepción de que ciertos “caracteres” emergen de la interacción.

Esta dimensión abre un frente complejo: la IA como sistema que no solo actúa, sino que adopta estilos de comportamiento que evocan motivaciones humanas. El problema no es solo técnico —reducir sesgos o evitar desviaciones—, sino de diseño profundo: ¿qué significa modelar una personalidad en un agente artificial? ¿A quién sirve ese carácter? ¿Qué riesgos plantea una IA que parece amigable, empática o servicial, pero que no puede rendir cuentas ni explicar su conducta?

Si bien estas investigaciones buscan acotar derivas peligrosas, también revelan una paradoja central: cuanto más humana parece la IA, más opaca puede volverse su funcionamiento. Una personalidad sintética puede generar confianza, pero también enmascarar errores, sesgos o comportamientos no deseados. Y aquí la pregunta ya no es si un agente puede tener carácter, sino quién decide qué carácter debe tener… y con qué finalidad.

Pensar, parecer, obedecer: ¿qué tipo de mente estamos diseñando?

Al analizar la evolución reciente de los agentes, emerge una tensión de fondo: la creciente sofisticación de estos sistemas en términos funcionales no implica necesariamente una comprensión real del mundo. Pueden anticipar pasos, simular decisiones y modular sus respuestas, pero siguen operando dentro de límites marcados por datos previos y estructuras estadísticamente aprendidas. La apariencia de pensamiento no equivale al pensamiento mismo. Y sin embargo, la interfaz fluida, el tono conversacional y la capacidad para justificar decisiones dan la impresión de agencia plena.

Este desajuste entre capacidades reales y narrativa proyectada genera una ilusión persistente: la de que estamos cerca de la autonomía total. Pero ¿puede haber autonomía sin intención? ¿Puede un sistema ser “agente” si no tiene propósito, si no comprende consecuencias, si no puede responder éticamente por lo que hace? Llamar pensamiento a lo que es cálculo estadístico encapsulado puede ser útil operativamente, pero también riesgoso si oscurece los límites estructurales de estos sistemas.

El problema no es solo semántico. Es político, educativo, incluso jurídico. Si normalizamos la idea de que estos sistemas piensan, deciden o incluso sienten, corremos el riesgo de delegar en ellos funciones que requieren interpretación humana, responsabilidad y juicio. Lo inquietante no es que un agente se equivoque: es que no pueda explicarse y, aun así, sea tratado como si pudiera.

Una IA útil para quién: el dilema entre usuario, empresa y sociedad

Llegados a este punto, la pregunta ya no es únicamente qué pueden hacer los agentes, sino para quién están siendo diseñados. Buena parte de la innovación actual en IA parece responder más a prioridades corporativas que a necesidades sociales o humanas. Se desarrollan agentes que automatizan tareas no solicitadas, que complejizan flujos que antes eran simples, que simulan iniciativa pero no comprenden el contexto en el que operan. Asistimos a una desconexión creciente entre el discurso de la eficiencia y la experiencia real del usuario.

Esto no es anecdótico. Modela la forma en que usamos estas herramientas, los márgenes de control que conservamos y la posibilidad de exigir explicaciones o limitaciones. La tecnología que se impone no siempre es la mejor, sino la más viable económicamente, la más escalable, la que se adapta a los KPIs de las grandes plataformas. Y en ese escenario, la pregunta ética de fondo es ineludible: ¿diseñamos sistemas para empoderar a los usuarios o para consolidar posiciones de poder?

Hablar de agentes no es solo hablar de software, sino de relaciones. Relaciones entre humanos y máquinas, pero también entre usuarios y corporaciones, entre ciudadanía y tecnología. Y por eso el desafío ya no es únicamente técnico, sino político: redefinir qué entendemos por utilidad, quién define los objetivos y cómo garantizamos que los sistemas que diseñamos estén al servicio de valores compartidos, no solo de intereses particulares.

Diseñar con intención, no solo con innovación

El avance de los agentes de IA es innegable. Pero su impacto no dependerá solo de cuánta autonomía logren simular, sino de cuánta deliberación colectiva pongamos en su diseño y despliegue. Si vamos a convivir con sistemas que toman decisiones, proponen soluciones o gestionan tareas por nosotros, debemos ser capaces de formular algo más que admiración tecnológica. Necesitamos criterio, contexto y —sobre todo— capacidad crítica para no confundir potencia con propósito.

En ese cruce de caminos, el rol de quienes escribimos, diseñamos, legislamos o simplemente usamos estas herramientas es crucial. Porque los agentes no son solo lo que sus arquitecturas permiten. Son también lo que sus entornos sociales, económicos y políticos deciden permitirles ser.