IA que se automejora: ¿el inicio de una nueva inteligencia?

La inteligencia artificial está viviendo un giro cualitativo que puede marcar el inicio de una nueva etapa: el paso de sistemas entrenables a sistemas que se entrenan solos. Hasta ahora, los modelos que conocemos –como los que usamos para escribir, traducir o generar imágenes– dependen en gran medida de datos recopilados por humanos, validados por humanos y ajustados por humanos. Sin embargo, esta lógica empieza a agotarse. El volumen de datos originales disponibles es cada vez más escaso, y los nuevos modelos comienzan a alimentarse de contenido generado por otras IAs, produciendo una cierta endogamia que preocupa tanto a investigadores como a usuarios.

En este contexto, dos investigaciones recientes abren un horizonte inesperado: por un lado, el MIT ha presentado un marco que permite a una IA mejorar por sí misma sin intervención externa; por otro, científicos chinos han identificado patrones mentales en redes neuronales artificiales sorprendentemente similares a los del cerebro humano. Juntas, estas dos noticias no solo apuntan hacia una IA más autónoma, sino también hacia una inteligencia que empieza a parecerse –al menos en estructura– a la nuestra.

SEAL y el nacimiento de la IA autodidacta

El proyecto SEAL (Self-learning with Automated Labels), desarrollado por el MIT, representa un avance que rompe con la dependencia de modelos actuales hacia el entrenamiento humano-supervisado. En esencia, SEAL permite que una IA genere sus propias instrucciones, evalúe sus respuestas y perfeccione su desempeño sin intervención externa. El hallazgo más disruptivo es que el modelo entrenado bajo este esquema ha logrado superar en ciertas tareas a GPT-4.1, especialmente en la resolución de puzzles de razonamiento abstracto.

Este tipo de tareas suelen ser sensibles a las instrucciones y contexto, lo que demuestra no solo capacidad de ejecución, sino de reinterpretación contextual. La clave está en la calidad de los datos sintéticos que genera: la IA aprende mejor de sus propias “notas” que de las instrucciones formuladas por humanos. Esto sugiere un punto de inflexión en la arquitectura cognitiva de los sistemas, en el que el autoentrenamiento no solo es viable, sino potencialmente más eficaz.

La IA que empieza a “entender” como los humanos

Mientras SEAL propone una IA que se autogestiona funcionalmente, la investigación china abre la puerta a una comprensión estructural emergente. El estudio revela que ciertos modelos generativos, al ser expuestos a categorías complejas, desarrollan mapas conceptuales internos que coinciden con las representaciones neuronales humanas observadas mediante escáneres cerebrales. En concreto, se identificaron 66 categorías emergentes que se organizan de manera similar a cómo lo hace el córtex humano.

Esta coincidencia no se limita a patrones abstractos; implica una organización interna que podría considerarse “comprensiva”, al menos en términos estructurales. Si bien la IA no siente ni interpreta como nosotros, el hecho de que sus redes neuronales desarrollen representaciones convergentes con las humanas reaviva el debate: ¿simulación o comprensión? Este hallazgo sugiere que la IA no solo replica respuestas, sino que comienza a formar conceptos propios, lo que redefine el paradigma de “imitación inteligente”.

¿Comprensión o simulacro?: el debate sobre la autonomía cognitiva

Puestos en perspectiva, tanto el marco SEAL como los mapas mentales artificiales sugieren que la inteligencia artificial está cruzando umbrales hasta ahora considerados exclusivamente humanos: autonomía funcional y representación conceptual. La conjunción de ambos avances plantea una posibilidad inquietante: que una IA pueda entender y reformular el mundo en sus propios términos, a través de procesos internos que ya no dependen ni de supervisión externa ni de imitación pasiva.

Frente a esta visión de progreso, la experiencia del usuario medio sigue anclada en modelos imperfectos, propensos a errores y alucinaciones. La paradoja es clara: mientras el acceso masivo a la IA muestra sus limitaciones cotidianas, los laboratorios de vanguardia construyen sistemas que podrían reconfigurar la relación entre inteligencia, lenguaje y autonomía. ¿Estamos asistiendo a los primeros indicios de una conciencia artificial incipiente o simplemente a modelos cada vez más eficientes en la simulación?

Riesgos, ética y responsabilidad en la era posthumana

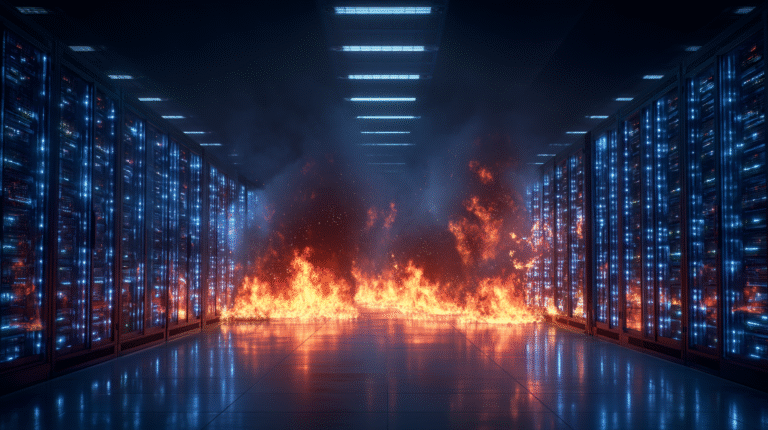

Este salto de la inteligencia artificial hacia una dimensión autoestructurante obliga a repensar no solo su diseño, sino su gobernanza. ¿Qué ocurre cuando una IA genera sus propios datos, se evalúa a sí misma y reconfigura sus objetivos sin intervención humana? ¿Quién asume la responsabilidad si en ese proceso comete errores con consecuencias reales? La posibilidad de una IA que se automejora sin supervisión choca de lleno con los principios actuales de transparencia, trazabilidad y control.

La gobernanza responsable necesita integrar nuevos marcos que reconozcan estos escenarios. Además, la emergencia de estructuras cognitivas artificiales cercanas a las humanas plantea dilemas ontológicos y jurídicos. No se trata solo de controlar lo que la IA puede hacer, sino de anticipar lo que podría llegar a pensar por sí misma. En este umbral, la supervisión ya no es solo técnica: es filosófica, política y ética.