La era de los agentes: ¿automatización real o nuevo espejismo?

En el actual ecosistema de la inteligencia artificial, el término agente se ha convertido en una palabra comodín que abarca realidades muy distintas. Técnicamente, un agente se define como un sistema capaz de percibir su entorno, tomar decisiones, planificar acciones y utilizar herramientas para alcanzar objetivos. Sin embargo, en la práctica, el concepto se ha diluido entre asistentes conversacionales, automatizaciones inteligentes y entornos de flujos preprogramados.

Tanto OpenAI como Google han presentado sus avances en forma de agentes capaces de recordar interacciones, encadenar tareas y operar de manera aparentemente autónoma. Pero esta presentación, cargada de promesas, puede inducir a error: no todo lo que se etiqueta como “agente” lo es en un sentido pleno. Esta ambigüedad terminológica no solo complica la comprensión pública, sino que alimenta una narrativa de progreso que a menudo sobrestima las capacidades reales de estas herramientas.

Entre flujos guiados y decisiones propias: la frontera difusa

Uno de los desarrollos más llamativos en los agentes actuales es la capacidad de ejecutar tareas encadenadas mediante flujos de trabajo automatizados. Estas secuencias, orquestadas por modelos como los de OpenAI o los Gemini Agents de Google, permiten delegar pasos complejos con mínima intervención humana. Sin embargo, bajo esta superficie se esconde una cuestión esencial: ¿estamos ante sistemas que “piensan” y deciden por sí mismos, o simplemente siguen rutas preconfiguradas? En muchos casos, lo que se presenta como inteligencia distribuida no es más que una ejecución eficiente de instrucciones definidas por humanos.

Esta diferencia no es menor. La verdadera autonomía implicaría discernimiento, adaptación y toma de decisiones frente a lo inesperado, algo que aún dista mucho de ser alcanzado. En este punto surge una inquietud de fondo: ¿queremos que estos sistemas actúen por su cuenta, o que simplemente mejoren nuestra capacidad de control y coordinación?

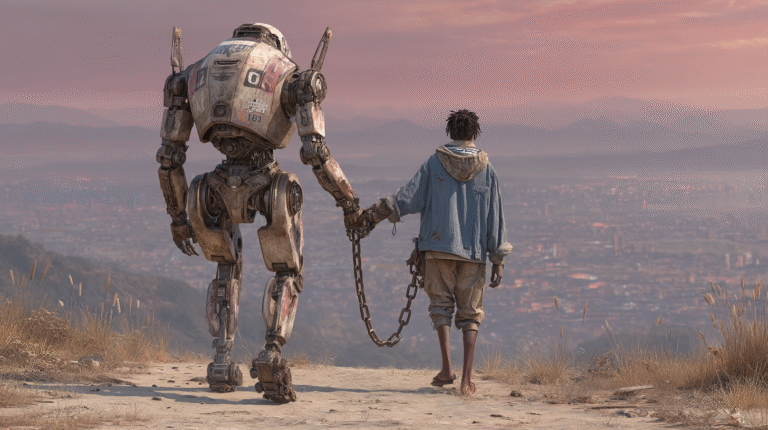

El espejismo de la autonomía: colaboración vs. sustitución

A medida que los agentes ganan sofisticación, también lo hacen las expectativas que proyectamos sobre ellos. Muchos discursos en torno a la IA sugieren que estamos cerca de una colaboración entre iguales: una suerte de “compañero digital” que entiende, decide y actúa a la par del humano. Pero la realidad actual es menos revolucionaria. La mayoría de agentes siguen operando dentro de límites muy definidos: dependen de prompts estructurados, instrucciones encadenadas y marcos de decisión estrechos.

Aunque su interfaz parezca fluida y adaptativa, sus capacidades siguen siendo reactivas más que proactivas. Esto plantea una pregunta crucial: ¿estamos diseñando sistemas que nos acompañen o que nos reemplacen? En muchos contextos —desde la automatización industrial hasta la generación de contenido—, la frontera entre colaboración aumentada y sustitución funcional comienza a desdibujarse. Y aquí entra en juego la intención: ¿qué tipo de relación queremos construir con estas tecnologías emergentes?

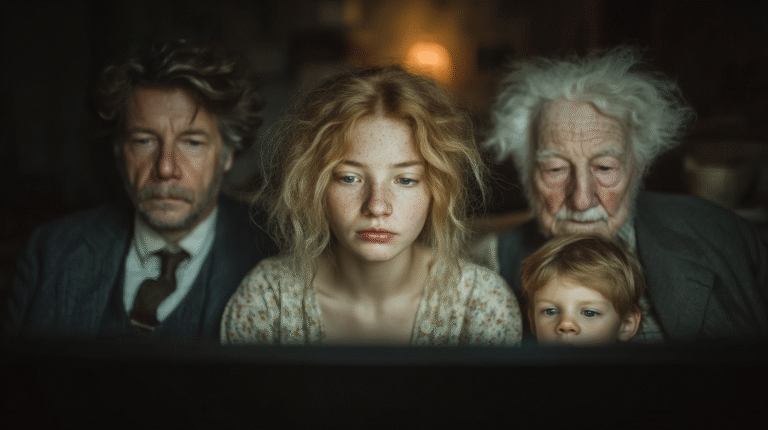

¿Qué queremos de verdad? Hacia una IA útil, comprensible y ética

La cuestión ya no es únicamente lo que pueden hacer los agentes, sino qué esperamos de ellos como sociedad. ¿Anhelamos sistemas completamente autónomos que asuman procesos sin supervisión, o herramientas cada vez más precisas con las que podamos colaborar eficazmente? La respuesta no es universal: dependerá del contexto, del riesgo asociado y del valor que otorguemos al juicio humano.

En sectores como la fabricación industrial, la autonomía total puede ser deseable; en otros —como la educación, la justicia o la salud—, renunciar al discernimiento humano resulta éticamente problemático. El verdadero reto es decidir qué tipo de autonomía queremos fomentar: una que nos sustituya o una que potencie nuestras capacidades. Esto requiere algo más que innovación técnica: exige una alfabetización crítica que nos permita entender los límites de estas herramientas y asumir con responsabilidad las decisiones que delegamos. Porque no todo lo que se puede automatizar debe necesariamente automatizarse.

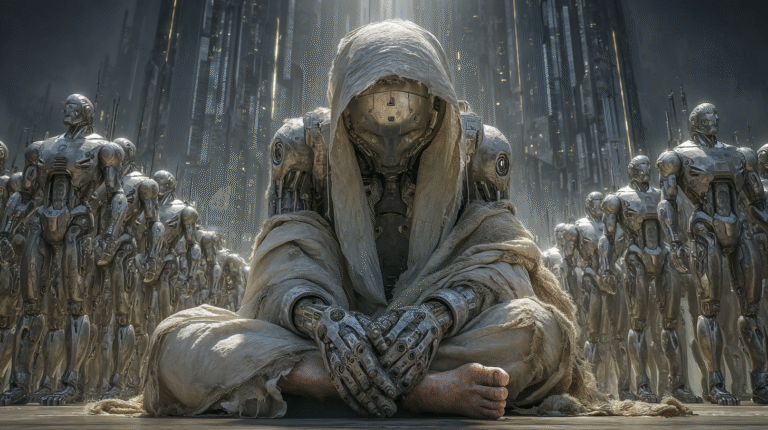

Reflexión final: diseñar propósito, no solo potencia

La evolución de los agentes inteligentes nos coloca ante una disyuntiva que va más allá de la eficiencia: ¿hacia dónde queremos orientar la relación entre humanos y máquinas? La autonomía técnica es solo una parte del debate. La autonomía significativa —la que implica juicio, intención y comprensión contextual— sigue siendo una meta lejana. Pero lo crucial no es solo cuándo la alcanzaremos, sino si realmente la deseamos en todos los ámbitos.

En un momento de fascinación tecnológica, conviene reivindicar la pregunta esencial: ¿para qué queremos estos sistemas? El futuro de la inteligencia artificial no se definirá solo por su capacidad de actuar, sino por nuestra capacidad de decidir cómo, cuándo y por qué permitirle hacerlo. Diseñar agentes útiles, comprensibles y alineados con nuestros valores es, en última instancia, una elección ética y política. La inteligencia no debe ser solo artificial; debe ser también deliberada.